Le but de notre projet étant de traiter des données multilingues, à travers la réalisation d’une chaîne de traitement textuel à partir de l’écriture de différents scripts, nous avons du d’abord choisir le mot ou le syntagme sur lequel construire notre projet: un mot ou un syntagme en français, en anglais, en espagnol et en russe. Pour cela, avons décidé de suivre des critères que nous avons établi nous-mêmes afin d’obtenir des résultats pertinents :

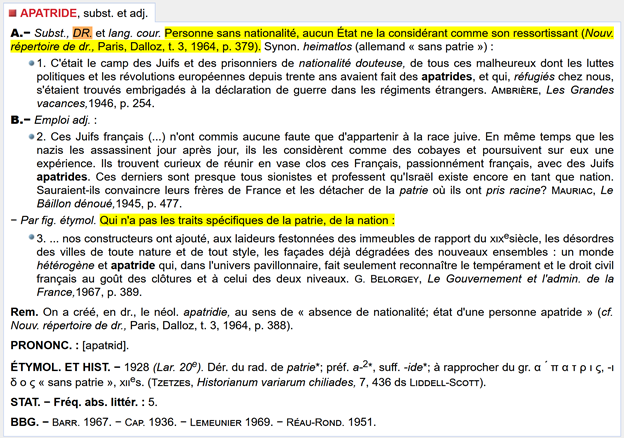

En prenant en compte nos critères et les difficultés à trouver le « bon » mot, nous avons finalement décidé de travailler avec des mots concernant le fait d’être « apatride ». Nous avons eu un aperçu du phénomène de l’apatridie grâce au contexte lexical du mot « apatride » ou « apatridie » dans les différentes langues. En outre, les mots peuvent potentiellement révéler des problèmes sociétaux idiosyncrasiques ou oubliés, ce qui serait intéressant à découvrir.

Nous nous sommes focalisés sur des articles d’actualité et des témoignages, afin d’éviter la rigidité des textes juridiques et des définitions de dictionnaire. Le corpus a donc été formé par des articles de presse, des blogs et certains sites officiels gouvernementaux ou d’organisations non gouvernementales. Par conséquent, nous avons dû chercher des pages ayant pour thème l’apatridie et contenant plusieurs occurrences du mot « apatride ». Nous nous sommes donc appuyés sur les paramètres avancés des moteurs de recherche pour améliorer la recherche manuelle.

Les recherches se sont avérées plus longues que prévu dans toutes les langues, mais surtout en russe, nous obligeant à faire une recherche plus fine à partir de notre culture générale et de notre connaissance du passé des pays russophones.

Compte tenu de la diversité et de la quantité limitée d’informations sur la situation des apatrides que nous avons trouvé, nous avons décidé de ne pas faire de différence entre les divers usages du mot dans les différentes langues. Ainsi, par exemple, pour l'espagnol, du point de vue sémantique et lexical, nous avons considéré les différents pays et régions hispanophones comme un seul groupe de pays pour nous simplifier les recherches (malgré les fortes différences régionales et nationales qui existent, par exemple, en Amérique latine). La bonne récollection d'URL dépendait de ce sacrifice.

Notre script est écrit presque dans sa totalité en Bash et HTML, sauf pour l’incorporation de deux programmes en Perl et quelques lignes de CSS. Vous pouvez consulter sa structure bien détaillée ci-dessous.

La fonction du script est facilement identifiable. Etant donné que nous disposons d’un fichier d’URLs, on traite le contenu de chaque lien afin d’en extraire les informations textuelles nécessaires pour analyser les contextes sémantiques et lexicaux des mots choisis. Toutes ces informations sont sauvegardées dans de fichier .txt ou .html et affichées dans des tableaux HTML pour faciliter leur accès et pouvoir les partager plus facilement. Comme on peut le voir, le but est simple et sa conceptualisation aussi.

Néanmoins, nous devions prévoir tout possible problème. L’enjeu était, en effet, de penser les possibles solutions au différents scenarios auxquels nous pourrions faire face. Ainsi, pour éviter de perdre les sites qui refusent l’accès à travers la commande curl , nous avons dû d’incorporer l’utilisation d’agents user pour simuler d’être des utilisateurs de ceux-ci. Ensuite, nous devions incorporer des lignes capables de traiter différents encodages, pour avoir la majeure quantité de données possibles. En outre, car nous voulions éviter toute perte d’information, nous avons ajouté un programme Perl qui nous a permis de récupérer l’encodage des URL que nous n’avions pas pu obtenir avant.

Ces éléments ajoutés ont rendu le script très bavard et difficile à comprendre. Raison pour laquelle nous avons décidé d’incorporer aussi certaines fonctions en vue de simplifier la lecture et la corp de notre code. Finalement, en sachant que nous aurions utilisé le logiciel iTrameur, nous avons incorporé deux boucles for destinées à préparer et concaténer le corpus que finalement nous analyserions sur ce logiciel. L’usage d’iTrameur est décrit dans la section Analyse avec l’interprétation des données.