Architecture du projet

" Un corpus de veille : le journal Le Monde "

Partie 1 : « Le Monde en Surface »

Partie 2 : « Le Monde Profond »

Document de travail - Décembre 2005

Fleury Serge, CLA2T/SYLED Serge.fleury@univ-paris3.fr

1 Sommaire

5 Partie 1 : « Le Monde en Surface »

5.1 La plateforme d’archivage des Fils de Presse

5.2 Le projet Fil(s) de Presse

5.3 Architecture du projet « nuage de mots »

6 Partie 2 : « Le Monde Profond »

6.1.2 Préparation et manipulation des données

6.1.2.1 Traitements automatiques

6.1.2.2 Traitements complémentaires

6.1.3 Synthèse des traitements

6.1.4 Traitements lexicométriques

7 Parcours du site : présentation des données et outils disponibles

7.3.1 Corpus Chronologique pour Lexico3

7.3.2 Corpus textuel au format XML

7.3.3 Corpus XML/Lexico3 par jour et thématique (France, International, Société…)

7.3.4 Corpus thématique complet pour Lexico3

7.3.5 Corpus thématique quotidien pour Lexico3

7.3.6 Corpus thématique complet pour Lexico3 avec indication de rubrique

7.3.7 Corpus thématique quotidien pour Lexico3 (version dite V2)

7.6 Spécificités chronologiques

7.8.1 Générateur de corpus Thématique

7.8.2 Générateur de corpus Thématique avec filtrage de formes

7.8.3 Extracteur de corpus Thématique avec filtrage de formes

7.8.4 Extracteur de corpus complet avec filtrage de formes

7.8.5 Générateur de corpus Thématique (dit version v2)

7.8.6 Générateur de corpus Thématique (dit version v2) avec filtrage de formes

7.8.7 Extracteur de corpus Thématique (dit version v2) avec filtrage de formes

7.8.8 Extracteur de corpus complet (dit version v2) avec filtrage de formes

9.1.1 Exemple de rapports construits avec Lexico3

9.1.1.1 Principales caractéristiques de la partition : DATE

9.1.1.2 Spécifs - Part : DATE Parties sélectionnées : "040125"

9.1.1.3 Graphes de ventilation de formes

9.2.1.1 Les nuages de Tags chez Technocrati

9.2.1.3 AlertInfo, un agrégateur RSS de la presse française

9.2.1.5 TagClouds (« Nuage de mots »)

9.2.1.7 10x10 : images du monde

9.2.1.8 Projet « Post Remix » (Washington Post)

9.2.2.1 Conversation : De la représentation visuelle à la complexité documentaire

9.2.2.2 Blog Technologies du Langage (par Jean Véronis)

9.2.3 Liens et développements autour de RSS

9.3.3 Présentation complémentaire

2 Table des figures

Figure 1 : Archivage des fils, arborescence

Figure 2 : Nuage de mots sans lien

Figure 3 : Nuage de mots avec liens

Figure 4 : Nuages de mots avec "carte des sections" (1 section = 1 carré = 1 article)

Figure 5 : Architecte initiale « en amont »

Figure 6 : Architecture modifiée « en amont »

Figure 7 : Schéma du lexique construit

Figure 8 : Architecture "en aval"

Figure 9 : Interface Chronofil

Figure 10 : Chronofil -Ventilation de la forme LAICITE (Fils Le Monde)

Figure 11 : Chronofil -Ventilation de la forme LAICITE (Fil AFP)

Figure 12 : Interface Chronofiltre

Figure 13 : Sortie Chronofiltre

Figure 14 : Interface ChronofiltreL3

Figure 15 : Sortie ChronofiltreL3

Figure 16 : Interface Chronofiltagger

Figure 17 : Sortie Chronofiltagger

Figure 18 : Interface Chronomonde

Figure 19 : sortie Chronomonde

Figure 20 : Interface Recherche

Figure 21 : page d'accueil du site

Figure 24 : corpus format Lexico

Figure 26 : page "les mots du monde"

Figure 27 : page "spécificités chronologiques"

Figure 29 : MKCorpusLeMonde-extracteur

Figure 33 : page Recherche (2)

Figure 34 : le moteur de requête (1/3)

Figure 35 : le moteur de requête (2/3)

Figure 36 : le moteur de requête (3/3)

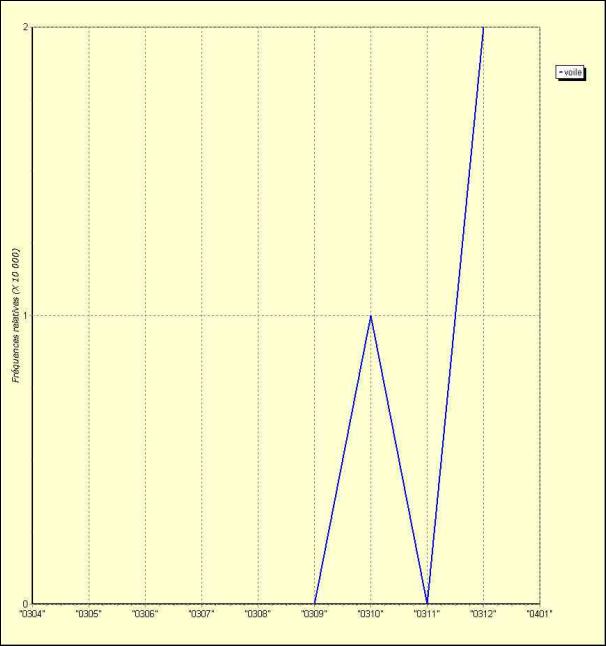

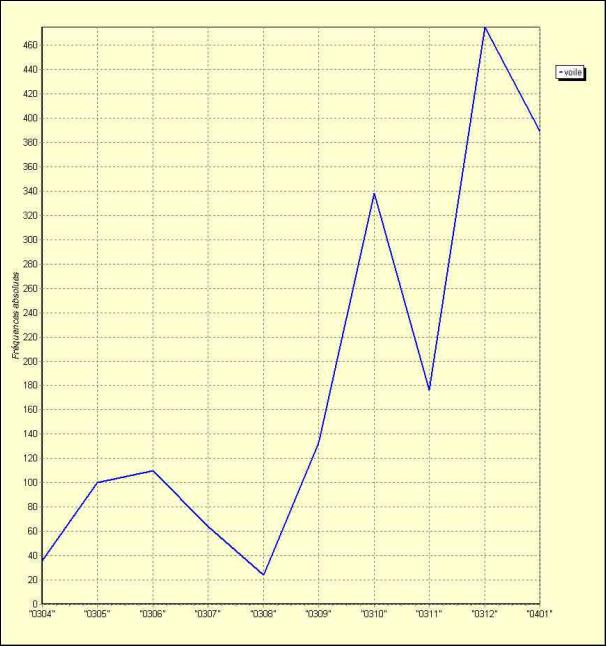

Figure 42 : Graphique de ventilation (voile) 1/2

Figure 43 : Graphique de ventilation (voile) 2/2

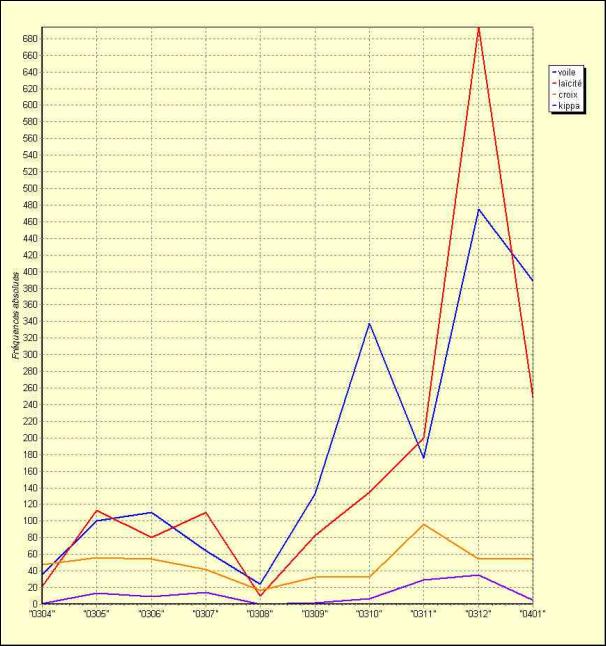

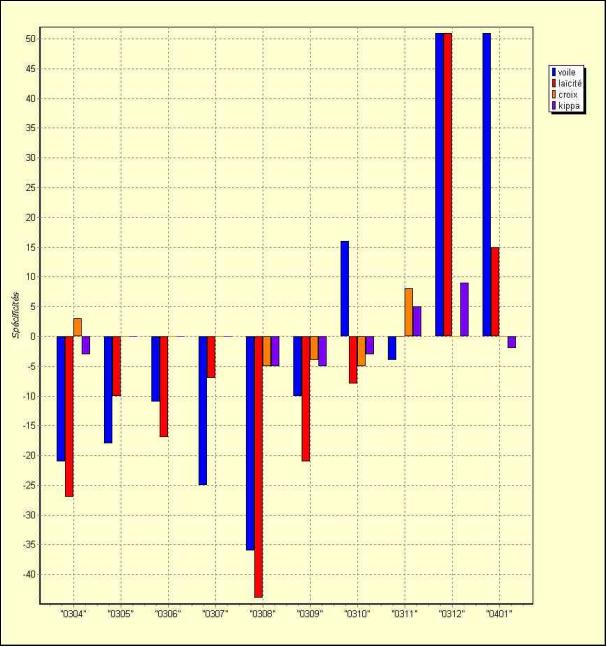

Figure 44 : Graphique de ventilation (voile, laïcité, croix, kippa) 1/2

Figure 45 : Graphique de ventilation (voile, laïcité, croix, kippa) 2/2

Figure 47 : Amazon "In the Beginning...was the Command Line"

Figure 48 : Menu "concordance" sur Amazon

Figure 49 : Nuage de mots "concordance".

Figure 50 : Contextes "Concordance"

Figure 52 : tagcloud sur Fils du Monde

Figure 53 : Paramétrage du tagcloud LeMonde

Figure 55 : Projet NewsMap (france)

Figure 57 : Projet NewsCloud (Washington Post)

Figure 58 : des Tags pour visualiser des collections de bibliothèques

3 Préambule

Ce document présente d’une part (Partie 1) l’architecture construite pour traiter les fils RSS[1] mis à disposition sur le site Web du journal Le Monde (d’autres fils sont aussi traités dans cette architecture, en particulier celui du site de l’AFP) et d’autre part (Partie 2) l'architecture mise en œuvre pour construire et analyser un corpus chronologique de la version électronique du journal Le Monde.

Partie 1 « Le Monde en Surface »

L’architecture construite est composée de 2 modules.

Le premier (« Fil(s) de presse ») correspond au module permettant de traiter un fil de presse donné (au format RSS) et de construire des traitements sur le contenu de ce fil (au départ, un « nuage de mots »).

Le second (« Archivage des Fils de Presse ») correspond au module permettant d’archiver les fils de manière continue et automatique afin de constituer la mémoire de ces fils.

Ce projet a commencé en Octobre 2005 i.e. on dispose à ce jour d'un corpus de fils RSS archivés toutes les heures et d’une série d’outils de traitement de ces fils (en développement).

Partie 2 « Le Monde Profond »

Chaque version quotidienne du journal Le Monde est régulièrement récupérée sur le site web du journal[2] : dans sa version HTML et dans sa version PDF. La version HTML[3] du journal est traitée pour produire différents états :

un état quotidien des contenus textuels du journal sous la forme d'une version normalisée au format XML et une version compatible avec le logiciel Lexico3

des états statistiques quotidiens

Les états quotidiens des contenus textuels sont ensuite nettoyés et concaténés pour produire des corpus chronologiques couvrant l'ensemble des dates de récupération.

Le démarrage de ce processus a commencé le 12 avril 2003 i.e. on dispose à ce jour d'un corpus regroupant l'ensemble des versions électroniques de chaque journée depuis cette date.

4 Le(s) site(s) du projet

Le site « officiel » du projet (dit « site CLMC ») est en accès restreint[4] à l’adresse suivante :

Hypertoile : http://sfmac.no-ip.com/corpusLeMonde/[5]

Une partie du projet « Le Monde en Surface » est visible en ligne et sans restriction à cette adresse : http://tal.univ-paris3.fr/filpresse/

De même, une partie des résultats construits pour la partie du projet « Le Monde Profond » est aussi disponible sans restriction aux adresses suivantes :

Weblog (pluri)TAL:

http://tal.univ-paris3.fr/blogtal/

On trouvera en particulier sur ce blog des rapports de navigation textométrique ou des résultats produits dans le cadre de ce projet.

Rapports Lexico3 :

http://www.cavi.univ-paris3.fr/ilpga/ilpga/tal/lexicoWWW/rapportsL3.htm

Rapports Lexico3 et spécificité chronologique :

http://www.tal.univ-paris3.fr/sfleury/veille.htm

5 Partie 1 : « Le Monde en Surface »

Ce projet est composé de 2 modules.

Le premier (« Fil(s) de presse ») correspond au module permettant de traiter un fil de presse donné (au format RSS) et de construire des traitements sur le contenu de ce fil (au départ, un nuage de mots).

Le second (« Archivage des Fils de Presse ») correspond au module permettant d’archiver les fils de manière continue et automatique afin de constituer la mémoire de ces fils.

5.1 La plateforme d’archivage des Fils de Presse

Un processus expérimental a été mis en place pour archiver les fils de presse. L'idée est la suivante :

- on a à disposition le corpus Le Monde depuis Avril 2003[6] (cf Partie 2 : « le Monde PROFOND »)

- on peut aussi avoir accès au fils RSS publiés quotidiennement (« le Monde EN SURFACE »)

En archivant régulièrement les fils on a donc à portée de main le PROFOND et la SURFACE. Le processus mis en place aspire régulièrement les fils visés et créé des pages de navigation pour donner à voir les données archivées et les nuages de mots créés sur chacun des fils (cf infra le projet « Fil(s) de Presse » : programme construisant un nuage de mots à partir des contenus textuels présents dans un fil donné). Les données sont visibles ici :

http://sfmac.no-ip.com/fils-presse-arch/index.xml (accès restreint)

L’archivage mis en place concerne les fils du journal Le Monde (cf infra) et celui de l’AFP[7]. La figure suivante donne une représentation de l’organisation de cet archivage :

Figure 1 : Archivage des fils, arborescence

Le processus d’archivage est déclenché toutes les heures et produit à chaque lancement un archivage des fils, des pages de navigation et les données nécessaires pour construire les nuages de mots.

5.2 Le projet Fil(s) de Presse

Le programme construit prend en entrée des fils RSS disponibles sur des sites de presse (Le Monde[8], Le Figaro[9], Libération[10]…) et produit des résultats donnant à voir :

- des nuages de mots

- une présentation des fils scrutés au format HTML et des comptages lexicométriques à partir des contenus textuels des descriptions des articles (disponibles dans les fils) mis à la disposition par les journaux.

Les figures suivantes présentent les différents types de nuages construits :

Figure 2 : Nuage de mots sans lien

Dans cette première figure, le nuage de mots donne à voir l’ensemble des mots présents dans les descriptions des articles des fils d’un journal en ligne à un moment donne (ici Le Figaro).

Figure 3 : Nuage de mots avec liens

Dans la seconde, on peut voir un nuage similaire dans lequel chaque mot donne accès via un clic aux contextes dans lesquels ce mot apparaît (colonne de droite) : le contexte est constitué par le titre de l’article, sa description et son URL.

Figure 4 : Nuages de mots avec "carte des sections" (1 section = 1 carré = 1 article)

Dans la troisième, on

y voit toujours le même nuage de mots sur la gauche, dans lequel chaque mot

donne accès via un clic à une « représentation cartographique[11] » du contenu du fil scruté dans

laquelle le contenu textuel de la description d’un article est représenté par

un carré, les articles contenant le mot cliqué sont associées à des carrés

rouges ![]() et les autres à des carrés blancs

et les autres à des carrés blancs ![]() . Chaque carré est donc associé à un article

en ligne (si on clique sur le carré on accède à l’article en ligne).

. Chaque carré est donc associé à un article

en ligne (si on clique sur le carré on accède à l’article en ligne).

Dans les trois figures, la taille de la police de caractères utilisée pour afficher le mot dans le nuage est déterminée par la fréquence du mot dans l’ensemble des articles scrutés pour un journal donné.

5.3 Architecture du projet « nuage de mots »

Dans le projet initial [Herrington, 2005], l’architecture « en amont » de l’application a l’allure suivante :

Figure 5 : Architecte initiale « en amont »

L’application lit des flux RSS et déclenche un parser RSS (écrit en PHP) qui a pour tâche de sélectionner les zones de texte à explorer puis de lancer une opération de segmentation de ces contenus textuels en ne retenant que les mots non présents dans une liste prédéterminée (mots vides). L’architecture maintenue pour le projet présenté ici est la suivante :

Figure 6 : Architecture modifiée « en amont »

Le principe général est conservé, tout le code est réécrit en Perl, parser compris. Tous les mots présents dans les contenus textuels scrutés sont conservés. Les mots retenus et comptés sont sauvegardés au format XML. Le fichier produit a l’allure suivante :

Figure 7 : Schéma du lexique construit

Dans ce schéma, l élément words contient la liste de tous les mots (et leur fréquence) pour un fil de presse donné, l’élément item contenant la liste de tous les mots pour un article donné contenu dans ce fil.

On présente ci-dessous un extrait du lexique construit :

<?xml version="1.0" encoding="iso-8859-1"?>

<?xml-stylesheet type="text/xsl" href="parserss.xsl"?>

<wordcounts>

<source>LIBERATION</source>

<time>Wed Oct 26 08:06:28 2005</time>

<words>

<word text="de" count="16" />

<word text="le" count="5" />

<word text="la" count="5" />

<word text="d" count="5" />

…

</words>

<items>

<item url="http://www.liberation.fr/page.php?Article=332624" title="">

<description><![CDATA[Mort du dessinateur aux personnages diaphanes et angéliques, rendu célèbre par un générique d'Antenne 2.]]></description>

<title><![CDATA[Feu Folon]]></title>

<words>

<word text="Mort" text2="Mort" />

<word text="du" text2="du" />

<word text="dessinateur" text2="dessinateur" />

<word text="aux" text2="aux" />

<word text="personnages" text2="personnages" />

<word text="diaphanes" text2="diaphanes" />

<word text="et" text2="et" />

<word text="angéliques" text2="angeliques" />

<word text="rendu" text2="rendu" />

<word text="célèbre" text2="celebre" />

<word text="par" text2="par" />

<word text="un" text2="un" />

<word text="générique" text2="generique" />

<word text="d" text2="d" />

<word text="Antenne" text2="Antenne" />

<word text="2" text2="2" />

</words>

</item>

…

</items>

</wordcounts>

Une modification mineure a été réalisée dans la grammaire du fichier lexique produit par rapport à l’application initiale. La présence de caractères accentués dans les mots posant des problèmes pour la seconde partie de l’application (celle utilisant le script établissant le lien entre le mot et ses contextes), un attribut a été ajouté dans les éléments décrivant les mots, celui-ci contenant après transcodage, la forme graphique normalisée du mot sans caractères accentués (générique est réécrit generique).

Dans un deuxième temps, l’application construit le nuage des mots en utilisant le lexique produit et en appliquant sur la sortie XML contenant ce lexique une feuille de style XSL (utilisant un script Javascript).

Figure 8 : Architecture "en aval"

Cette architecture « en aval » maintient intégralement le principe présenté dans [Herrington, 2005]. Plusieurs modifications ont cependant été apportées :

La feuille de style initiale a d’abord été réécrite pour ne produire qu’un nuage de mot sans lien i.e. sans liens vers les contextes originaux contenant les mots scrutés.

Elle a aussi été modifiée pour affiner les sorties produites (contextes ou carte des sections)

5.4 Boîte à outils

5.4.1 Chronofil

Chronofil est un programme CGI permettant de construire en ligne un graphique de ventilation d’une forme donnée dans l’ensemble des Fils de presse archivés. L’interface web de ce programme est disponible à cette adresse :

http://sfmac.no-ip.com/cgi-bin/chronofil.cgi

On y accède aussi à partir de la page d’accueil du site du projet (rubrique Chronofil dans le menu de gauche). La figure suivante présente cette page :

Figure 9

: Interface Chronofil

Une fois entrée une forme graphique, le programme déclenché scrute les fils de

presse archivés et construit in fine le graphique de ventilation correspondant

à la forme. Les figures qui suivent montrent la ventilation de la forme

LAICITE :

Figure 10 : Chronofil -Ventilation de la forme LAICITE (Fils Le Monde)

Figure 11

: Chronofil -Ventilation de la forme LAICITE (Fil AFP)

5.4.2 Chronofiltre

Chronofiltre est un programme CGI permettant de sélectionner en ligne les contenus textuels des fils archivés contenant un mot donné. L’interface web de ce programme est disponible à cette adresse :

http://sfmac.no-ip.com/cgi-bin/chronofiltre.cgi

On y accède aussi à partir de la page d’accueil du site du projet (rubrique Chronofiltre dans le menu de gauche). La figure suivante présente cette page :

Figure 12 : Interface Chronofiltre

Une fois entrée une forme graphique, le programme déclenché scrute les fils de presse archivés et construit in fine une page regroupant les contenus des fils contenant la forme cherchée. Deux états sont disponibles : un premier état concatène l’ensemble des contenus textuels sans filtrage des doublons, un deuxième filtre les éventuels doublons. De plus ces 2 états sont disponibles sous 2 formats : HTML et XML (avec feuille de style XSLT).

La figure suivante présente le résultat (filtré) sur la forme LAICITE :

Figure 13 : Sortie Chronofiltre

5.4.3 ChronofiltreL3

ChronofiltreL3 est un programme CGI permettant de construire en ligne un corpus au format Lexico3 rassemblant l’ensemble des Fils de presse archivés. L’interface web de ce programme est disponible à cette adresse :

http://sfmac.no-ip.com/cgi-bin/chronofiltreL3.cgi

On y accède aussi à partir de la page d’accueil du site du projet (rubrique ChronofiltreL3 dans le menu de gauche). La figure suivante présente cette page :

Figure 14 : Interface ChronofiltreL3

La figure suivante présente un extrait du résultat produit :

Figure 15 : Sortie ChronofiltreL3

5.4.4 Chronofiltagger

Chronofiltagger est un programme CGI permettant de construire en ligne un corpus étiqueté avec treetaggerrassemblant l’ensemble des Fils de presse archivés. L’interface web de ce programme est disponible à cette adresse :

http://sfmac.no-ip.com/cgi-bin/chronofiltagger.cgi

On y accède aussi à partir de la page d’accueil du site du projet (rubrique Chronofiltagger dans le menu de gauche). La figure suivante présente cette page :

Figure 16 : Interface Chronofiltagger

La figure suivante présente un extrait du résultat produit :

Figure 17 : Sortie Chronofiltagger

6 Partie 2 : « Le Monde Profond »

6.1 Chaînes de traitement

6.1.1 Récolte des données

Le journal Le Monde met à la disposition de ses abonnés la version électronique du journal dans différentes formats : une version au format PDF et 2 versions au format HTML (une avec image et l'autre sans). La version PDF et la version HTML sans image sont récupérées sur le site du journal quotidiennement et stockées sur disque. Seule la version HTML simplifiée est traitée par la chaîne de traitement décrite infra.

6.1.2 Préparation et manipulation des données

Après récupération, chaque version quotidienne est soumise à différentes manipulations.

6.1.2.1 Traitements automatiques

Des scripts Perl ont été construits pour réaliser en plusieurs étapes différentes opérations :

Une première étape consiste à "normaliser" la version originale en utilisant le programme webxref utilisé dans les projets TYPWEB et SENSNET (cf Phase 1).

Une seconde étape construit une version XML et Lexico3 de la version électronique quotidienne du journal (cf Phase 1).

Une troisième étape construit l'index quotidien des mots du journal (cf Phase 1).

Une quatrième étape permet d'obtenir une version complète du corpus au format XML (par concaténation et structuration) (cf Phase 1).

Enfin une dernière étape permet de construire à la volée les différents corpus thématiques (quotidiens et complets) (cf Phase 2).

6.1.2.2 Traitements complémentaires

Chaque version quotidienne du corpus au format Lexico3 est insérée dans les corpus de chronologique complet de référence (corpus complet, corpus France, corpus INTERNATIONAL). Certaines balises sont ajoutées pour marquer le changement de semaine, de mois ou d'année.

Un programme se charge ensuite d'insérer la balise RUBRIQUE dans le corpus complet au format Lexico3.

Cette étape de préparation des données n'est pas réalisée quotidiennement, mais en général une fois par quinzaine.

6.1.3 Synthèse des traitements

|

Phase n°0 |

|

|

Récupération des données sur le site du Monde.fr

|

|

|

Phase n°1 |

|

|

load-webxref.pl |

Lancement de la normalisation WEBXREF |

|

load-makeCorpusL3-date.pl |

Génération de corpus quotidien XML et pour L3 Index des mots |

|

load-makeAllThemaCorpus.pl |

Génération des corpus thématiques (toutes rubriques confondues) |

|

load-makeAllThemaCorpus-v2.pl |

Génération des corpus thématiques (toutes rubriques confondues) (v2) |

|

load-makeThemaCorpus.pl |

Génération des corpus thématiques "France" et "International" |

|

load-makeThemaCorpus-international-v2.pl |

|

|

load-makeThemaCorpus-france-v2.pl |

Génération du corpus thématique "France" (v2) |

|

load-makeThemaCorpus-societe.pl |

Génération du corpus thématique "Société" |

|

load-makeThemaCorpus-societe-v2.pl |

Génération du corpus thématique "Société" (v2) |

|

load-makeThemaCorpus-select.pl |

Génération de corpus thématique à la volée |

|

load-makeThemaCorpus-select-v2.pl |

Génération de corpus thématique à la volée (v2) |

|

Phase n°3 |

|

|

"Rebalisage" manuel ou automatique des corpus produits

|

|

|

Phase n°4 |

|

|

Traitements lexicométriques

|

|

6.1.4 Traitements lexicométriques

A l'issue de l'étape précédente, on dispose quotidiennement d'un état du corpus prêt pour être analysé par Lexico3. (cf en annexe un exemple de rapport construit avec Lexico3)

6.2 Boîte à outils

6.2.1 ChronoMonde

Chronomonde est un programme CGI permettant de construire en ligne un graphique de ventilation d’une forme donnée dans le corpus complet. L’interface web de ce programme est disponible à cette adresse :

http://sfmac.no-ip.com/cgi-bin/chronomonde.cgi

On y accède aussi à partir de la page d’accueil du site du projet (rubrique Chronomonde dans le menu de gauche). La figure suivante présente cette page :

Figure 18 : Interface Chronomonde

Une fois entrée une forme graphique et après avoir choisi une partition pour la ventilation (JOUR, MOIS, ANNEE), le programme déclenché scrute le corpus et construit in fine le graphique de ventilation correspondant à la forme. La figure qui suit montre la ventilation de la forme LAICITE sur une partie du corpus (Avril 2003 – Novembre 2004), partition MOIS :

Figure 19 : sortie Chronomonde

6.2.2 Moteur de recherche

Un moteur de recherche permet de lancer des requêtes dans la version HTML du corpus archivé. Ce moteur prend appui sur le moteur d'indexation swish-e[12] qui est paramétré pour indexer l'ensemble des pages HTML du corpus original.

Figure 20 : Interface Recherche

6.3 Perspectives

6.3.1 Travaux en cours

Mise en place d’outils :

- pour structurer les données textuelles traitées

- les récupérer efficacement avant traitement

- et enfin pour les analyser

7 Parcours du site : présentation des données et outils disponibles

7.1 La page d'accueil du site

Figure 21 : page d'accueil du site

Le menu de gauche de cette page permet d'accéder aux rubriques présentées ci-dessous.

7.2 Présentation

Présentation générale du projet

7.3 Corpus

Présentation des différentes versions des corpus disponibles

La chaîne de traitement présentée infra construit différentes versions des données associées aux versions électroniques du journal.

REMARQUE : Suite au changement de la formule du quotidien le 06.11.2005, seule la version dite v2 présentée infra est disponible à compter du 08/11/2005 (la version v1 dite « all-thema » est maintenue). De plus à cette même date, la rubrique France et la rubrique Société sont visiblement fusionnées en une seule rubrique dite "Politique-Société".

7.3.1 Corpus Chronologique pour Lexico3

Un corpus complet préparé pour être analysable par Lexico3 est construit par la chaîne de traitement : il rassemble l'intégralité des états électroniques du journal depuis le démarrage de ce projet. Ce corpus est partitionné de la manière suivante : ANNEE, MOIS, SEMAINE, DATE, RUBRIQUE, PAGE (article). En raison de la taille volumineuse de ce corpus, celui-ci est disponible sous la forme de plusieurs fichiers (un fichier couvre une période de 6 mois environ) dont la concaténation construit une version couvrant l’ensemble de la période disponible.

7.3.2 Corpus textuel au format XML

Un corpus complet au format XML et regroupant les contenus textuels est également construit à l'issue de la chaîne de traitement. Ce corpus est utilisé dans le moteur de requête présenté infra. Le schéma ci-dessous décrit la structure de ce corpus.

7.3.3 Corpus XML/Lexico3 par jour et thématique (France, International, Société…)

La chaîne de traitement construit des "corpus quotidiens" au format XML et au format Lexico3.

Figure 24 : corpus format Lexico

7.3.4 Corpus thématique complet pour Lexico3

Des corpus supplémentaires sont construits sur le même principe que le corpus chronologique complet mais en ne conservant que des rubriques sélectionnées : FRANCE (regroupant les rubriques « France » et « France-Société » du journal), INTERNATIONAL (la rubrique « international » du journal), SOCIETE (la rubrique « société » du journal). Il est possible ne pas se restreindre à ces rubriques particulières et de construire un corpus thématique donné : un générateur de corpus thématique (i.e. lié à une rubrique donné) est disponible dans la chaîne de traitement mise en œuvre (cf infra).

7.3.5 Corpus thématique quotidien pour Lexico3

La chaîne de traitement construit des "corpus quotidiens" au format Lexico3 qui contrairement aux précédents intègre une indication de rubrique. Les articles de navigation (menu et sommaire de la version HTML) ne sont pas conservés dans cette version de données.

7.3.6 Corpus thématique complet pour Lexico3 avec indication de rubrique

Ce corpus résulte de la concaténation des précédentes données.

7.3.7 Corpus thématique quotidien pour Lexico3(version dite V2)

Cette version du corpus se distingue de la précédente de la manière suivante :

Dans la version précédente, le processus de filtrage mis en place des parties textuelles se fait en utilisant la commande Unix "lynx -dump" sur les pages HTML originales, or ces pages contiennent systématiquement un sommaire de chaque rubrique pour une journée donnée. On avait donc, sur chaque version "nettoyée" une "surcharge" textuelle correspondant au rappel de ces rubriques.

Dans cette nouvelle version, le processus de filtrage textuel se fait toujours avec la même commande Unix mais un filtrage préalable des zones textuelles est opéré : on commence par isoler les contenus textuels correspondant au nom de la Rubrique, du Titre de l'article et de son Contenu "propre". Les pages HTML originales sont assez bien structurées et permettent d'isoler ces zones et a fortiori de négliger le sommaire qu'elles contiennent aussi.

7.4 Version HTML

La version originale (construite par les éditeurs de la version électronique du journal) des états quotidiens est disponible dans sa version HTML (simplifiée). Cette version permet de reconstruire « à la volée » des corpus thématiques en utilisant les outils construits à cet effet (cf infra).

7.5 Les Mots du Monde

Dictionnaire des mots du journal et leur fréquence pour chaque jour (format HTML et XML)

Figure 26 : page "les mots du monde"

La chaîne de traitements construit pour chaque journée traitée un index des mots utilisés et leur fréquence.

7.6 Spécificités chronologiques

L'ensemble des calculs des spécificités chronologiques construites avec Lexico3 pour certaines dates.

Figure 27 : page "spécificités chronologiques"

Des calculs de spécificités (par jour) sont construits par Lexico3 pour certaines journées, pour le moment cette opération est réalisée manuellement.

7.7 Rapports Lexico3

Ensemble des rapports d'analyse construits avec Lexico3

Des rapports d'analyse réalisés avec Lexico3 sont construits à partir des différentes versions disponibles du corpus. A ce jour une vingtaine de rapport ont été construits (cf infra).

7.8 Outils

Outils associés aux projets[13]

Cette page donnent des liens vers les outils utilisés ou construits pour ce projet.

7.8.1 Générateur de corpus Thématique

Un script Perl peut construire à la demande un état complet regroupant l’ensemble des articles d’une même rubrique du journal sur l’ensemble de la période disponible. On dispose à ce jour de tels états pour les rubriques : France, International et Société.

Ce script utilise l’application Lynx.

“Lynx is a fully-featured World Wide Web (WWW) browser for users on Unix, VMS, and other platforms running cursor-addressable, character-cell terminals or emulators. That includes vt100 terminals, other character-cell displays, and vt100 emulators such as Kermit or Procomm running on PCs or Macs. Lynx was a product of the Distributed Computing Group within Academic Computing Services of The University of Kansas. Lynx was originally developed by Lou Montulli,Michael Grobe, and Charles Rezac.Garrett Blythe created DosLynx and later joined the Lynx effort as well. Following the departures of Lou and Garrett for positions at Netscape in the summer of 1994, Craig Lavender provided support services for Lynx, and Ravikumar Kolli for DosLynx. Currently Lynx is being maintained and supported by members of the Internet community coordinated via the lynx-dev mailing list. Lynx is copyrighted by the University of Kansas and is distributed without restrictions on usage or redistribution under the GNU General Public License.”

Mode d’emploi

perl MKCLM-TH.pl -at repOut repIn date thema thema2

Le script doit être lancé avec 4 paramètres et une option complémentaire :

L’option –at permet de re-diriger les sorties vers le répertoire repOut

Les paramètres à utiliser sont :

|

repIn |

le répertoire contenant un état quotidien du journal au format HTML |

|

date |

la date traitée |

|

thema |

la rubrique à conserver |

|

thema2 |

réécriture du nom de la rubrique après nettoyage typographique |

Ce script utilise l’application Lynx (cf supra).

7.8.2 Générateur de corpus Thématique avec filtrage de formes

Un script Perl permet de construire un état complet regroupant l’ensemble des articles d’une même rubrique et contenant un motif textuel donné (une expression régulière[14] permettant de sélectionner un groupe de mots par exemple).

Ce script utilise l’application Lynx (cf supra).

Mode d’emploi

perl MKCLM-TH-querystring.pl -at repOut repIn date thema thema2 queryString

Le script doit être lancé avec 5 paramètres et une option complémentaire :

L’option –at permet de re-diriger les sorties vers le répertoire repOut

Les paramètres à utiliser sont :

|

repIn |

le répertoire contenant un état quotidien du journal au format HTML |

|

date |

la date traitée |

|

Thema |

la rubrique à conserver |

|

Thema2 |

réécriture du nom de la rubrique après nettoyage typographique |

|

queryString |

le motif à rechercher dans les articles à conserver |

7.8.3 Extracteur de corpus Thématique avec filtrage de formes

Un script Perl/Tk permet d’extraire une sous-partie d’un corpus thématique (construit par les précédents scripts) en ne conservant que les articles contenant un motif donné (exprimé là encore par une expression régulière permettant de sélectionner une famille de mots).

Exemple d’utilisation :

A partir du corpus Thématique France, extraction des articles contenant les formes graphiques : sécurité, sécuritaire, etc.

Ci-dessous l’interface de cet extracteur :

Figure 29 : MKCorpusLeMonde-extracteur

MKCorpusLeMonde-Extracteur :

Ce programme prend en entrée un corpus thématique du journal Le Monde et un motif (une expression régulière) et il extrait tous les articles contenant le motif : le format en sortie est compatible avec Lexico3.

Mode d’emploi :

Ce programme existe sous 2 formes :

(1) Un script Perl/Tk qui doit être lancé dans une fenêtre de commandes en respectant la syntaxe suivante :

perl MKCorpusLeMonde-Extracteur -at repOut corpus queryString

Le script doit être lancé avec 2 paramètres et une option complémentaire :

L’option –at permet de re-diriger les sorties vers le répertoire repOut

Les paramètres à utiliser sont :

|

Corpus |

Le nom du corpus thématique utilisé |

|

queryString |

le motif à rechercher dans les articles à conserver |

(2) Une application Perl/Tk (un exécutable) dans un environnement Windows. Pour le lancer, double-clic sur le programme.

INPUT :

Le corpus thématique (i.e. correspondant à une rubrique donnée) est issu de la chaîne de traitement présentée dans ce document. Pour charger ce corpus, utiliser le bouton "browse" puis sélectionner le corpus thématique souhaité. Le corpus en entrée contient un balisage propre à son utilisation avec Lexico3. Ce balisage tient compte essentiellement de l'aspect chronologique du corpus. On y trouve donc en général des balises du type ANNEE, MOIS, SEMAINE, DATE, PAGE (cette dernière balise correspondant en fait aux articles). Les valeurs des balises précédentes correspondent aux périodes temporelles associées aux parties du corpus visées. Ce balisage est maintenu par l'extracteur : le corpus en sortie aura une structure similaire.

FILTRE :

Les filtres permettent de sélectionner des articles (dans le corpus thématique) contenant une chaîne de caractère correspondant au filtre écrit. Un filtre est écrit sous la forme d'une expression régulière.

Exemple : \bsécurit[a-z]+\b

Ce motif permet de rechercher tous les mots qui commencent (\b) par la chaîne de caractères 'sécurit' (peu importe la casse) suivie d’une répétition de un à « une infinité » de n'importe quel caractère compris entre a et z avant la fin du mot (\b). Les mots couverts par ce motif sont par exemple : sécurité, sécurités, sécuritaire etc.

OUTPUT :

Le corpus obtenu à l'issue de l'extraction contient tous les articles du corpus initial contenant le motif décrit par le filtre. Ce corpus en sortie est compatible avec le format de fichier pour Lexico3. De plus, il est possible de relancer le processus d'extraction sur ce fichier pour par exemple affiner le processus de filtrage des articles. Les corpus issus du processus d'extraction sont horodatés, il est conseillé cependant de leur donner un nom plus précis.

7.8.4 Extracteur de corpus complet avec filtrage de formes

Un script Perl/Tk permet d’extraire une sous-partie du corpus complet en ne conservant que les articles contenant un motif donné (exprimé là encore par une expression régulière permettant de sélectionner une famille de mots).

Même principe que le précédent.

Nom du programme : MKCorpusLeMonde-Extracteur-complet.

7.8.5 Générateur de corpus Thématique (dit version v2)

7.8.6 Générateur de corpus Thématique (dit version v2) avec filtrage de formes

7.8.7 Extracteur de corpus Thématique (dit version v2) avec filtrage de formes

Même principe que ci-dessus.

7.8.8 Extracteur de corpus complet (dit version v2) avec filtrage de formes

En cours de développement

7.9 Query

Un moteur de requête qui permet pour le moment de lancer des requête sur un des états du corpus

Cette page donne accès à un moteur de requête sur la version XML du corpus. Le détail des outils mis en place dans ce moteur est détaillé infra. Ce moteur permet de lancer 2 types de requêtes :

- par date : on obtient en sortie, le contenu textuel du journal relatif à la date choisie. Dans la figure qui suit, la requête sur la date 2004-01-09 permet de recueillir l'intégralité des contenus textuels de cette journée.

- on peut aussi lancer une requête pour extraire les contenus textuels contenant une séquence textuelle choisie par l'utilisateur. Dans la figure qui suit, la requête lancée vise à recueillir tous les articles qui contiennent le mot "voile".

Les données utilisées à ce jour dans ce moteur sont constituées de 2 fichiers au format XML, le premier couvre la période suivante : du 12 avril 2003 au 10 décembre 2003 et du 14 décembre 2003 au 25 janvier 2004. Ces deux fichiers font respectivement 90 Mo et 55 Mo.

Des tests ont été opérés pour mesurer les temps de traitement nécessaires pour travailler sur ces données volumineuses dans le contexte web mis en place actuellement :

dans une utilisation sur un serveur local, les temps de réponse sont tout à fait satisfaisants

dans une utilisation externe, il faut compter une heure pour charger les données (1 des 2 fichiers), l'exécution des requêtes est ensuite assez rapide.

7.10 Recherche

Cet item donne accès à une page de formulaire permettant de lancer des requêtes (moteur de recherche) sur le corpus original "HTML simplifié et sans image". L'image qui suit montre le résultat d'une requête sur la recherche du mot "laïcité".

Figure 33 : page Recherche (2)

7.11 Le moteur de requête

Le moteur de requête en cours de développement reprend une application développée par John Udell[15] permettant de sélectionner et de récupérer les rubriques de son weblog classées thématiquement via l'utilisation d'une interface web utilisant des requêtes XPath[16].

Figure 34 : le moteur de requête (1/3)

Figure 35 : le moteur de requête (2/3)

Figure 36 : le moteur de requête (3/3)

7.12 Boîte à outils CGI

7.12.1 Chronofil

Cf supra

7.12.2 Chronofiltre

Cf supra

7.12.3 Chronomonde

Cf supra

7.12.4 ChronofiltreL3

Cf supra

7.12.5 Chronofiltagger

Cf supra

8 Références bibliographiques

2001, Valérie Beaudouin, Serge Fleury, Benoît Habert, Gabriel Illouz, Christian Licoppe, Marie Pasquier, "TyPWeb : décrire la Toile pour mieux comprendre les parcours", CIUST'01, Colloque International sur les Usages et les Services des Télécommunications, e-Usages, Paris, 12-14 juin (Version PDF)

2001, Cédric Lamalle, William Martinez, Serge Fleury, André Salem, Andrea Kuncova, Aude Maisondieu, "Dix premiers pas avec Lexico3", Manuel d'utilisation abrégé (Version PDF), (Version HTML) (sur le site de Lexico)

2002, Valérie Beaudouin, Serge Fleury, Marie Pasquier, Benoît Habert, Christian Licoppe, "TyPWeb : décrire la Toile pour mieux comprendre les parcours. Sites Personnels et sites marchands", in RESEAUX, Volume 20, n°116/2002, "Parcours Sur Internet", pages 19-52, FT&RD/Hermès

9 Annexes

9.1 Annexe Partie 1

9.1.1 Exemple de rapports construits avec Lexico3

On présente ici un rapport[17] construit sur le corpus complet avec indication de rubriques sur la période du 12 avril 2003 au 25 janvier 2004.

Cette première page donne une présentation générale de caractéristiques du corpus et un point d'entrée vers les résultats construits :

|

|

|

|

|

20814181 |

|

|

236878 |

|

|

1054349 |

|

|

95427 |

Principales caractéristiques de la partition : DATE

Spécifs - Part : DATE Parties sélectionnées : "040125", (1)

Graphique de ventilation pour la partition : MOIS (1)

Graphique de ventilation pour la partition : MOIS (2)

Graphique de ventilation pour la partition : MOIS (3)

Graphique de ventilation pour la partition : MOIS (4)

Graphique de ventilation pour la partition : MOIS (5)

9.1.1.1 Principales caractéristiques de la partition : DATE