![]()

Constitution d’un corpus web

dans le cadre du Projet TypWeb

France Télécom R&D

Université Paris 3/ILPGA

Juillet - Août 2000

Aude Maisondieu & Andréa Kuncova

![]()

Remerciements

Nous remercions Marie Pasquier, notre maître de stage, de nous avoir accueillies pour ce stage, de sa disponibilité, de ses conseils et de toute l’aide qu’elle nous a apportés tout au long de son déroulement.

Nos remerciements vont aussi aux autres stagiaires et CDD, Benoit, Samuel, Magida, pour leur esprit de camaraderie et leur compagnie durant ce stage.

Enfin à toutes les personnes du laboratoire qui se sont montrées amicales et souriantes, et qui ont fait en sorte que ce séjour à France Télécom R&D soit agréable.

Pour finir, nous tenons à exprimer toute notre reconnaissance et notre gratitude envers Serge Fleury, pour sa disponibilité et pour nous avoir permis d’intégrer l’équipe TypWeb durant ces deux mois.

Sommaire

1Introduction 4

2Objectif 5

2.1« Qu’est-ce qu’un corpus ? » 5

« Quel type de corpus a été constitué? » 5

3Contexte de travail 6

3.1Les aspirations 6

3.1.1Les aspirateurs 6

3.1.2Le choix des sites à aspirer 6

3.2Outils de modélisation des sites 7

4Observation des aspirations archivées4 7

4.1Exploration à partir d’outils 7

4.1.1Astra Site Manager (version de démonstration) 7

Observation des cartes 8

4.1.2Web Analyseur (version de démonstration) 9

4.1.3Bilan 10

4.2Exploration manuelle 10

4.2.1Méthode 10

4.2.2Bilan 11

4.2.3Hypothèses sur les causes d’une mauvaise aspiration 11

5Constitution d’un index des sites aspirés 13

5.1Quantification de l’état des aspirations 14

5.2Trois aspirateurs à évaluer 15

5.2.1Objectif 15

5.2.2Présentation des aspirateurs 15

5.2.2.1HTTrack 2.1 15

5.2.2.2Teleport Pro 1.29 16

5.2.2.3MemoWeb (version démonstration) 17

5.2.3Comparatif des aspirateurs 19

5.2.4Difficultés rencontrées lors de l’aspiration 20

6Outils de modélisation des sites 23

6.1WebXref 11 : un outil de « désossage » de sites 25

6.1.1Présentation 25

6.1.2Problèmes rencontrés 27

6.2Mktipo7 : un outil de normalisation de sites 27

6.2.1Présentation 27

6.2.2Problèmes rencontrés 28

7Conclusion 30

7.1Bilan du stage 30

7.2Perspectives 30

8Bibliographie 31

Nous avons effectué notre stage dans le laboratoire « Usages, Créativité et Ergonomie » (UCE) de France Télécom Recherche & Développement où nous avons participé au projet TypWeb.

Le projet TypWeb qui associe des chercheurs de France Télecom R&D (DIH/UCE) et de l’équipe TyPText (LIMSI - PARIS X - PARIS III) propose de fournir un cadre méthodologique et pratique de profilage de sites web et une typologie fine de ces sites. Le projet TypWeb bénéficie des travaux menés par l’équipe TyPText qui développe actuellement une architecture de profilage dans une optique inductive qui consiste à faire émerger des textes, considérés comme des agglomérats fonctionnellement cohérents, des traits de niveaux variés (linguistiques, structurels, typographiques …).

Nous avons contribué à la constitution d’un corpus de sites web, première phase du projet. Dans un premier temps, nous avons aspiré des sites web et, dans un second temps, nous avons procédé à la modélisation des donnés en utilisant des outils de modélisation de sites. A l’issue de ce travail, les sites sont normalisés – suivant les critères définis par l’équipe TypWeb – et sont au format XML.

Au cours de ce rapport nous présenterons la situation à notre arrivée, les différentes étapes de la constitution d’un corpus et les difficultés rencontrées.

Le principal objectif de notre stage est la constitution d’un corpus web. Ceci nous a amené à nous poser les questions suivantes : « qu’est-ce qu’un corpus ? » et « quel type de corpus a été constitué ? ».

Dans Les linguistiques de corpus, Habert et al. (1997) donnent la définition suivante d’un corpus :

« Nous proposons une définition de corpus encore plus restrictive que celle de (Sinclair, 1996, p.4) : un corpus est une collection de données langagières qui sont sélectionnées et organisées selon des critères linguistiques et extra-linguistiques explicites pour servir d’échantillon d’emplois déterminés d’une langue. » (p. 11).

On distingue deux grands types de corpus :

Corpus spécialisé : « se restreint à une situation de communication, un domaine, une langue de spécialité, c’est-à-dire un langage spécifique, très contraint du point de vue lexical, syntaxique, voire textuel, que l’on trouve dans les domaines scientifiques et techniques. » (Habert et al., 1997, p.38).

Corpus de référence : « un corpus de référence est conçu pour fournir une information en profondeur sur une langue. Il vise à être suffisamment grand pour représenter toutes les variétés pertinentes de cette langue et son vocabulaire caractéristique, de manière à pouvoir servir de base à des grammaires, des dictionnaires et d’autres usuels fiables. » (J. Sinclair, 1996, p.10)1.

Il peut s’agir d’un corpus spécialisé dans la mesure où ce corpus « se restreint à une situation de communication » : le web. Toutefois, le langage de notre corpus ne nous semble pas spécifique car les sites aspirés ne se rattachent pas à un domaine scientifique et/ou technique particulier. Donc on peut penser que c’est un corpus de référence. Or, ce corpus est-il « suffisamment grand pour représenter toutes les variétés pertinentes de la langue ? » (J. Sinclair, 1996, p.10) 2.

Nous ne sommes pas sûres que cela soit le cas ; par conséquent, le corpus constitué pourrait être un composant d’un corpus de référence. Une analyse lexicale, syntaxique, voire textuelle permettrait certainement de déterminer plus précisément le type de corpus dont il s’agit.

Afin d’atteindre l’objectif cité ci-dessus, nous avons dû passer par plusieurs étapes :

aspiration des sites personnels et marchands à partir de l’hypertoile,

comparaison et évaluation d’aspirateurs,

vérifications des aspirations,

mise en œuvre des outils de modélisation des sites web, à savoir webxref et mktipo,

passage des corpus des sites aspirés à un corpus « normalisé » (réécriture des sites dans le modèle XML).

Un aspirateur (en anglais browser off line) se charge de recopier tout ou partie d’un site web sur le disque dur : nous parlons alors de « site miroir ». L’intérêt principal de ces logiciels est de rendre accessible un site sur l’ordinateur lorsqu’on est déconnecté. En théorie, le site aspiré doit être une copie conforme de l’original3. Nous verrons plus loin que cela n’est pas le toujours cas. D’où l’importance du choix d’aspirateur avec lequel on travaille.

Face à la diversité des sites présents sur l’Internet, se pose le problème du choix des sites à aspirer. Dans son article Création de valeur sur l’Internet, Gensollen (1999) divise le web en deux domaines : le domaine marchand et le domaine non marchand. Il définit alors le web marchand comme « l’ensemble des sites pour lesquels l’information a été produite de façon marchande et qui sont financés soit par abonnement, soit par la publicité, soit par le commerce électronique. » Parallèlement les autres sites, qui constituent le « web gratuit » sont le fruit d’un travail bénévole et « les surfeurs qui s’y arrêtent ne contribuent pas significativement à leur financement ». Il s’agit principalement des pages personnelles des internautes, des sites universitaires, des sites publics, etc.

S’appuyant sur l’hypothèse proposée par Gensollen (1999), l’équipe TypWeb a choisi d’explorer d’une part les sites marchands représentatifs du web marchand et, d’autre part, les pages personnelles représentatives du web gratuit tant au niveau de leur contenu que des usages des concepteurs et des utilisateurs de sites.

A notre arrivée, les sites aspirés se composent d’environ 500 sites de pages personnelles et 100 sites marchands français (cf. annexe 1) choisis selon les critères suivants :

Critère de sélection pour les pages personnelles :

Un premier corpus a été constitué à partir des pages personnelles hébergées par Wanadoo. Les aspirations ont été lancées à partir du site leader (jura.speleo), puis complétées par des aspirations aléatoires.

Au cours de notre stage, nous avons constitué un second corpus de pages personnelles. La stratégie d’aspiration retenue est différente puisque l’on tient compte des parcours des utilisateurs. En effet, nous avons aspiré tous les sites personnels hébergés par le fournisseur d’accès Wanadoo visités au cours du mois de mars 2000 par les internautes du panel de NetValue (cf. annexe 2). Cela représente environ 580 sites personnels.

Critère de sélection pour les sites marchands :

Les sites aspirés correspondent aux entretiens menés dans le laboratoire (entretiens auprès des plus importants sites marchands français et de leurs prestataires de technologies, pour le commerce des biens tangibles). Nous avons poursuivi les aspirations des sites marchands déjà en cours en tenant compte des entretiens ayant déjà eu lieu ou programmés pour les mois à venir. Nous avons ainsi aspiré 40 sites marchands.

Actuellement, la chaîne de traitement élaborée dans le cadre du projet TypWeb se compose de deux outils : webxref et mktipo. Ces deux outils s’utilisent l’un après l’autre et permettent d’obtenir une modélisation des sites. Ils ont été au préalable mis au point et testés sur un sous-corpus par l’équipe TypWeb.

Ce sous-corpus de sites se compose d’un site marchand (www.aucland.fr), et de 15 sites personnels pour lesquels chaque URL commence par http://perso.wanadoo.fr/ (alferic, cryptozoo, davidd, frederic.grillot, jura.speleo, lafamille.ecker, lycee.noailles, mairie.aureilhan, manivelles, netonymy, palimpseste, serra, vincent.zemb, voyages.transversale, yekrik.yekrak).

Le choix des sites retenus est complètement subjectif. Toutefois, en ce qui concerne les sites personnels sélectionnés, le sous-corpus se fonde sur une connaissance a priori des sites puisqu’il contient des sites de différents types (i.e. sites de présentation de soi, sites thématiques et sites « divers »).

Avant notre arrivée, tous les sites étaient aspirés avec HTTrack version 2.025 et archivés sur CD-ROM. La première tâche que l’on nous a confiée était de vérifier les sites déjà archivés, et de comparer les sites en ligne et les sites miroirs stockés sur CD-ROM. Cette comparaison nous a permis d’évaluer l’état des aspirations et la performance de l’aspirateur utilisé. A l’issue de cette comparaison, nous avons finalement choisi d’utiliser un autre aspirateur.

Notons que le travail de comparaison est rendu difficile par l’évolution constante des sites. Effectivement, les sites actuellement en ligne ont parfois beaucoup évolué depuis leur première aspiration en 1999.

Pour réaliser cette comparaison, nous avons voulu nous aider de deux outils de cartographie de sites : Astra Site Manager et Web Analyseur. Ces outils ont été développés pour les webmasters afin de vérifier la cohérence des sites et de les optimiser. Plus précisément, ils permettent de vérifier les liens et de surveiller la topologie des sites (c’est-à-dire voir tous les répertoires des sites).

Ainsi, ces logiciels donnent rapidement une représentation visuelle des sites en faisant apparaître les liens et les nœuds des sites. Un environnement sous forme d'icônes est alors mis en place dans lequel il est possible de tester tous les éléments du site : liens, images, formulaires, etc. Il suffit de cliquer sur une icône pour simuler une action de navigation sur le site et obtenir un résultat.

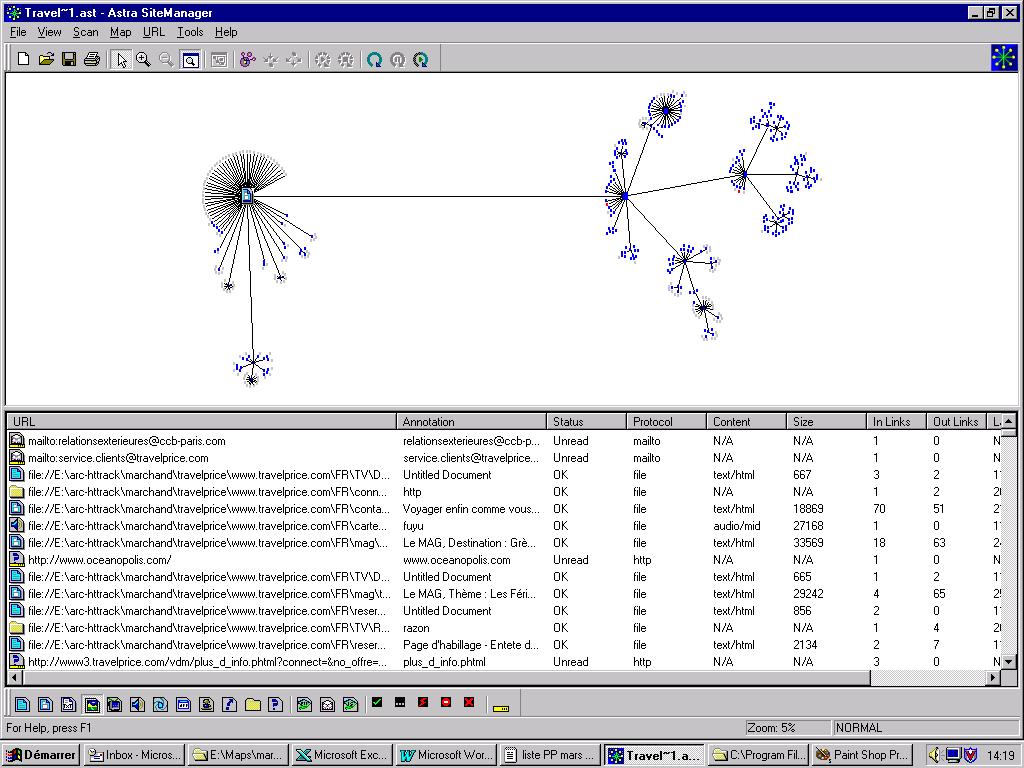

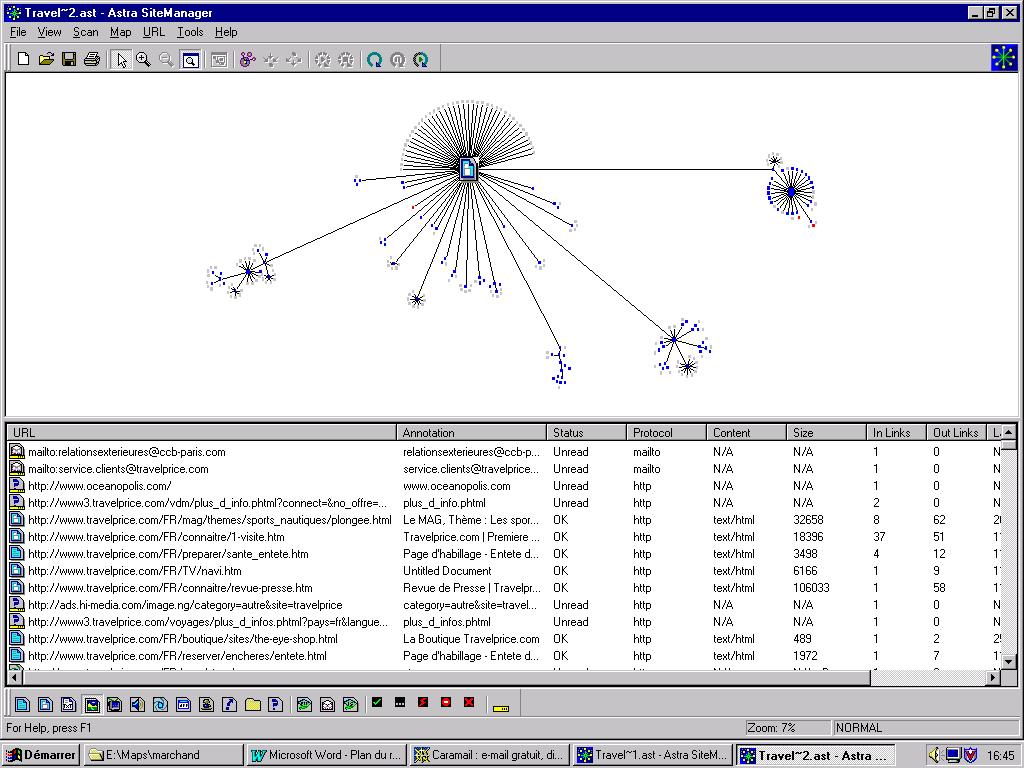

Astra Site Manager, développé par Mercury Interactive, est un outil disponible et en accès libre sur le site : http://www-svca.mercuryinteractive.com/fr/products/astrasitemanager/.

Cet outil parcourt l’intégralité d’un site web (en ligne ou en local) et construit progressivement une carte de ce site (cf. Figure 1 et Figure 2). Une fois le site parcouru et cartographié, Astra Site Manager produit un rapport qui synthétise toutes les propriétés du site (nombre d’URL, statuts des URLs, nombre de liens extérieurs, nombre de liens internes, etc.).

Astra Site Manager est relativement simple à manipuler ; toutefois, nous avons relevé quelques points pour utiliser au mieux ce logiciel :

Il faut toujours mettre la même adresse de départ pour la création de la carte du site aspiré et du site en ligne, dans le cas contraire nous n’obtenons pas la même représentation graphique.

Il faut toujours finir l’URL (en ligne) par « / » sinon les liens externes sont pris en compte et cartographiés.

Quand le nom d’un fichier contient un ou plusieurs blancs, le fichier n’est pas cartographié (hypothèse : est-ce pour cela que certaines pages ne sont pas aspirées ?).

On peut voir la structure du site plus facilement qu’avec Web Analyseur (cf. § Web Analyseur (version de démonstration)), on a une vue générale du site.

Figure 1 : Carte du site Travelprice archivé

Figure 2 : Carte du site Travelprice en ligne

D’après les Figure 1 et Figure 2, nous constatons que les cartes des sites en ligne et aspirés ne sont pas les mêmes car le site miroir est incomplet (aspiration partielle).

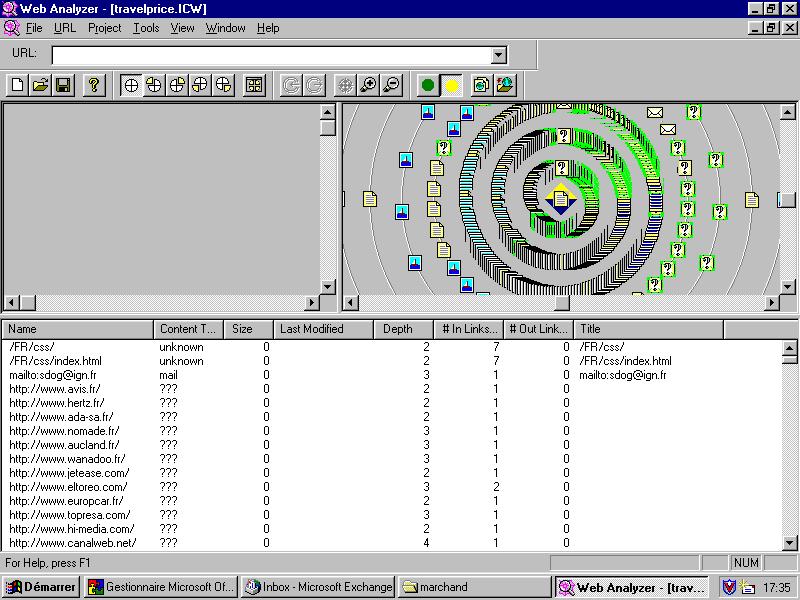

Tout comme Astra Site Manager, Web Analyseur permet de construire des cartes de sites. C’est un outil développé par InContexte, qui est disponible et en accès libre sur le site : http://www.Incontext.com/WAinfo.html.

Utilisant une version de démonstration, le logiciel ne fonctionne pas sur les sites en ligne. Nous n’avons donc pas pu l’utiliser pour la comparaison des sites en ligne et des sites aspirés. Néanmoins, nous présentons une carte réalisée sur un site miroir en guise d’illustration (cf. Figure 3). Cette carte fait clairement apparaître la constitution du site, puisque les icônes représentant les images, les textes et les fichiers sont nettement distingués.

En outre, nous avons constaté que le problème de mauvaise aspiration, qui apparaît lorsque le nom d’un fichier contient un ou plusieurs blancs rencontré avec Astra Site Manager, ne se manifeste pas avec Web Analyseur.

Figure 3 : Carte du site Travelprice archivé

N’étant pas en mesure de cartographier les sites en ligne avec Web Analyseur, nous avons préféré utiliser Astra Site Manager pour comparer les sites aspirés et en ligne.

Toutefois, l’exploration à l’aide de ces outils reste difficile et la difficulté augmente avec la taille du site (problème de lisibilité). De plus, l’exploration n’est pas exhaustive : elle ne nous permet pas de faire un bilan détaillé (liens, images, fichiers manquants) des différences entre le site aspiré et en ligne. Par conséquent, nous avons opté pour une exploration manuelle bien qu’elle soit plus longue à mettre en œuvre.

Nous avons donc eu recours à la comparaison manuelle des sites. Pour ce faire, nous avons exploré les sites archivés en cherchant ce qui n’avait pas été aspiré par rapport au site en ligne.

Dès lors, deux constats sont à faire à propos de cette méthode :

tout d’abord, la navigation dans les sites est l’unique moyen pour juger de la qualité des aspirations. Or, cette navigation n’est pas toujours exhaustive ;

ensuite, comme nous l’avons déjà indiqué, nous comparons des sites en ligne à un instant t avec des sites archivés à t -1 ans.

De ce fait, les résultats provenant de notre comparaison manuelle sont à nuancer.

Que ce soit pour les sites marchands ou les pages personnelles, nous avons relevé les points suivants :

sur la page principale (ou page d’accueil du site), les images sont souvent bien aspirées qu’elles soient au format gif ou jpg. En revanche, sur les pages de liens6, les images sont souvent non aspirées (à partir du deuxième niveau 7et plus) ;

les liens de retour à l’index ou à la page principale ne fonctionnent presque jamais. Par contre, lorsque le concepteur du site a créé un lien « page précédente » et/ou « page suivante » sur une page, il fonctionne.

Dans la plupart des cas, pour les sites personnels, les liens qui se trouvent dans une fenêtre de « menu » (frame) ne fonctionnent presque jamais.

Aussi bien pour les sites marchands que pour les pages personnelles, plus on va en profondeur dans les sites, plus les images et les liens ne sont pas aspirés ou mal aspirés.

En fonction de notre observation des sites d’origine et des sites archivés, et des régularités que nous avons mises à jour, nous avons tenté de trouver des explications sur les causes de mauvaises aspirations des sites. Ci-dessous, nous indiquons le problème observé et proposons les raisons pour lesquelles il apparaît.

les liens de retour à l’index ou à la page principale ne fonctionnent presque jamais

Ceci peut être dû à un problème de paramétrage de l’aspirateur. Par exemple, avec HTTrack, il est possible de paramétrer le sens dans lequel le robot va explorer le site avec l’option « mode de parcours ». Dans tous les cas, nous choisissons l’option « can go down » : l’aspiration se fait donc dans une seule direction, à savoir descendante.

les liens

A priori, il n’existe pas de régularités dans la mauvaise aspiration des liens ; toutefois nous avons pu observer quelques cas récurrents tels que :

une mauvaise aspiration des URLs contenant un ou plusieurs blancs, une virgule ou un point-virgule,

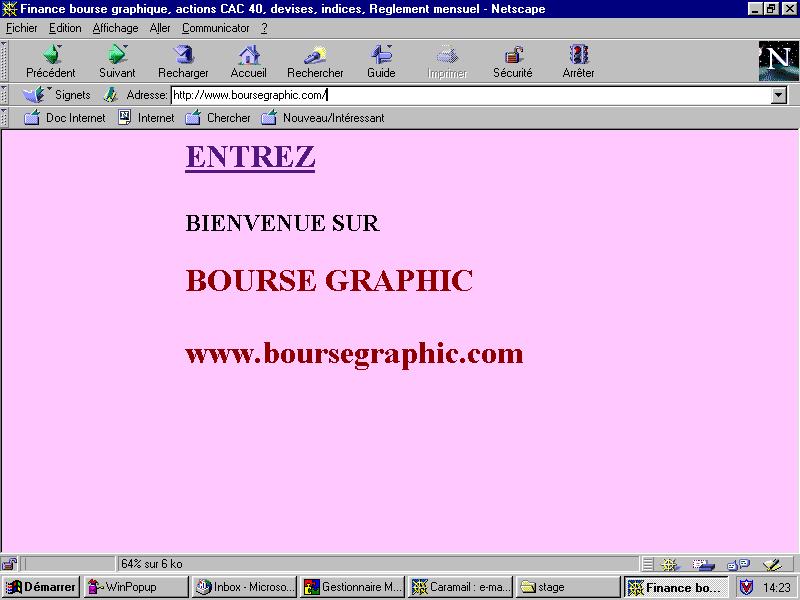

les pages à redirection, c’est-à-dire celles qui ont changé de fournisseur d’accès. Par exemple, c’est le cas du site : http://perso.wanadoo.fr/bourse.graphic (cf. Figure 4, p. 12),

les liens se trouvant dans plusieurs sous-répertoires (A HREF = « ../site/mal/bin.htm »). Voir par exemple le site personnel : http://perso.wanadoo.fr/albatros (cf. Figure 5, p. 13).

les raisons possibles de la mauvaise capture des images

les noms d’extension des fichiers d'images écrits en majuscule ( .GIF/.JPG) ne sont pas toujours pris en compte lors de l’aspiration,

les images qui se trouvent dans des sites extérieurs (ex. : IMG SRC= « http://…..) ne sont pas capturées,

les images qui sont appelées dans la source de façon suivante : ex. IMG SRC = « ../Images/Tapenbn.jpg » (site albatros) sont mal capturées (cf. Figure 5).

la version 2.02 d’HTTrack aspire mal les applets Java8

Deux autres types d’erreurs peuvent apparaître lors de la navigation et peuvent alors provenir des outils utilisés pour l’aspiration et l’archivage. Effectivement, nous avons remarqué les cas de figure suivants :

à propos de l’archivage des sites aspirés sur CD-ROM

Lorsque les noms de fichiers sont trop longs (plus de 64 caractères), le logiciel qui permet de graver ne les accepte pas. Il les remplace alors par un nom plus court. Il est possible que lorsque l'on navigue dans un CD-ROM d'archive, les noms de fichiers renommés ne correspondent plus aux liens internes des sites. C'est certainement une autre cause de mauvaise navigation dans les sites aspirés.

à propos de l’aspirateur HTTrack

HTTrack renomme les noms des fichiers du site aspiré quand ils sont trop longs. Les conséquences seraient les mêmes que pour les problèmes d’archivage.

Figure 4 : Exemple de redirection

<html xmlns:v="urn:schemas-microsoft-com:vml"

xmlns:o="urn:schemas-microsoft-com:office:office"

xmlns:w="urn:schemas-microsoft-com:office:word"

xmlns="http://www.w3.org/TR/REC-html40">

<!-- Mirrored from perso.wanadoo.fr by HTTrack/1.x [RX/PY'99] -->

<head>

<meta http-equiv=Content-Type content="text/html; charset=windows-1252">

<meta name=ProgId content=FrontPage.Editor.Document>

<meta name=Generator content="Microsoft FrontPage 4.0">

<meta name=Originator content="Microsoft Word 9">

<link rel=File-List href="../../../www.wanadoo.fr/pages_perso/html/exc_inconnu.html">

<link rel=Edit-Time-Data href="../../../www.wanadoo.fr/pages_perso/html/exc_inconnu.html">

<!--[if !mso]>

<style>

v\:* {behavior:url(#default#VML);}

<o:idmap v:ext="edit" data="1"/>

</o:shapelayout></xml><![endif]-->

<meta name=Version content=8.0.3429>

<meta name=Date content="11/28/96">

<meta name=Template content="C:\Program Files\Microsoft Office\Office\HTML.DOT">

</head>

<body bgcolor=white background="../Images/Image17.gif" lang=FR link=blue

vlink=purple style='tab-interval:35.4pt'>

<div class=Section1 style="width: 842; height: 1027">

Figure 5 : Exemple d’images et de liens problématiques dans le site Albatros (extrait du code source d’une page de liens)

Ce travail doit conduire à la construction d'un index des sites aspirés sous forme de tableau Excel. Cet index contient pour chaque site (cf. annexe 3) :

son nom

son adresse http

son type :

Pour les pages personnelles, nous avons ajouté des informations si des indications supplémentaires permettent d'enrichir la description initiale des sites : il s’agit d’informations thématiques portant sur le contenu du site. Nous nous sommes limités à trois cas de figure :

les sites de présentation de soi (signature),

les sites thématiques : dans ce cas-là, nous avons indiqué quel était le thème principal du site (par exemple, voyages, informatique, cuisine, etc.),

les autres types de sites qui ne sont pas catégorisés comme des sites personnels. Il s’agit des sites associatifs, des sites de mairie, lycées, ambassades, etc. Dans ce cas, nous avons spécifié la nature du site (ex. association, mairie, lycée, etc.).

Pour les sites marchands, nous avons indiqué le secteur d’activité du site (ex. voyages, jeux, informatique, VPC, etc.).

l’extraction des méta-tags qui apparaissent dans la page d’accueil, si elles existent

la langue ou les langues utilisées dans le site

la date d’aspiration

l’aspirateur utilisé

l’état de l’aspiration

les problèmes rencontrés lors de l'aspiration

les pages problématiques dans le site miroir issu de l'aspiration

la date d’archivage

Nous avons ainsi exploré manuellement 159 pages personnelles sur 542 au total ce qui nous a permis d'établir une quantification de l’état des aspirations en fonction de notre objectif, c’est-à-dire obtenir des sites miroirs identiques (ou du moins quasi identiques) aux sites en ligne.

L’exploration manuelle et exhaustive de 159 sites personnels aspirés avec HTTrack 2.02, nous a permis de quantifier l’état de l’aspiration.

Voici les comptages que nous avons obtenus :

Date d’aspiration : août, septembre, octobre 1999

Date d’archivage : 24 janvier 2000

Changement d’adresse de sites : 3

Sites complets : 27

Pour qu’un site soit complet, il faut que tous les éléments de la page apparaissent visuellement à l’écran, c’est-à-dire qu’il faut voir tout le texte, toutes les images, tous les éléments multimédias (son, vidéo…) et que tous les liens fonctionnent.

Sites non aspirés : 17

Sites « intermédiaires » : 109

Nous avons divisé la catégorie « sites intermédiaires » en trois sous-catégories :

les sites plus ou moins complets dans lequel il ne manque qu’une image, ou bien dans lequel seul un lien ne fonctionne pas : 19

Dans ce cas là, il est possible que :

l’image qui manque soit externe au site,

cela provienne de l’aspirateur HTTrack qui renomme les noms des fichiers du site aspiré quand ils sont trop longs,

et, s’il manque une page, cela peut provenir du logiciel de gravage qui renomme les fichiers trop longs.

les sites intermédiaires c’est-à-dire ceux dans lesquels les liens ne marchent pas dans des niveaux plus bas et les images manquent dans des niveaux plus bas : 42

les sites où seule la page d’accueil a été aspirée : 43

Notons pour finir que chaque sous-catégorie de l’état d’aspiration décrit ci-dessus se trouvent dans l’index des sites aspirés (cf. colonne état d’aspiration).

Notre objectif est d’obtenir une aspiration la plus fidèle possible du site en ligne.

Nous avons utilisé trois aspirateurs : MemoWeb 3 version de démonstration, HTTrack version 2.1 et Teleport Pro version 1.29. Disposant d’un PC et travaillant dans l’environnement Windows NT, nous nous sommes limitées aux aspirateurs existant pour ce type de plate-forme.

HTTrack est un logiciel gratuit et disponible sur le web (cf. note 5, p. 7 et Tableau 1, p. 19). Il propose de nombreuses options de paramétrage qui permettent de s’adapter aux aléas du web (nouvelles technologies, contenus des sites, transmission des données, etc.). Les options qui nous ont été les plus utiles sont les suivantes :

la mise à jour rapide d’un miroir et la possibilité de continuer un transfert interrompu (rupture de connexion, crash, etc.). Cette option est particulièrement utile lorsque l’ordinateur bloque : nous pouvons alors arrêter l’aspiration et la relancer plus tard.

l’utilisation de filtres selon le type, la position du lien, la profondeur, la taille des fichiers, la taille du site, la possibilité d'accepter ou de refuser certains sites ou fichiers. Cela nous permet principalement de ne pas aspirer les liens externes, ou de « forcer » l’aspiration de certains éléments (par exemple, les images).

la gestion de proxy, qui est une option nécessaire car nous nous connectons sur internet par l’intermédiaire d’un proxy.

le mode de stockage des données : soit les noms de fichiers sont aspirés avec une structure originale préservée, soit en mode séparé (un répertoire pour les html, un autre pour les images). Dans notre cas, l’option est très importante car nous voulons avoir un miroir fidèle du site en ligne et garder la structure hiérarchique originelle du site.

la génération d’un fichier log optionnel permet de repérer les erreurs et de consulter des commentaires en fin d’aspiration.

la possibilité d’insérer une liste des URLs de sites à aspirer successivement. Nous avons utilisé cette option pour lancer l’aspiration de tous les sites personnels (cf. annexe 2).

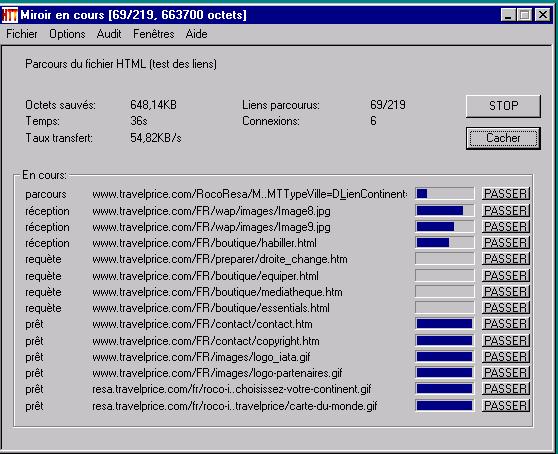

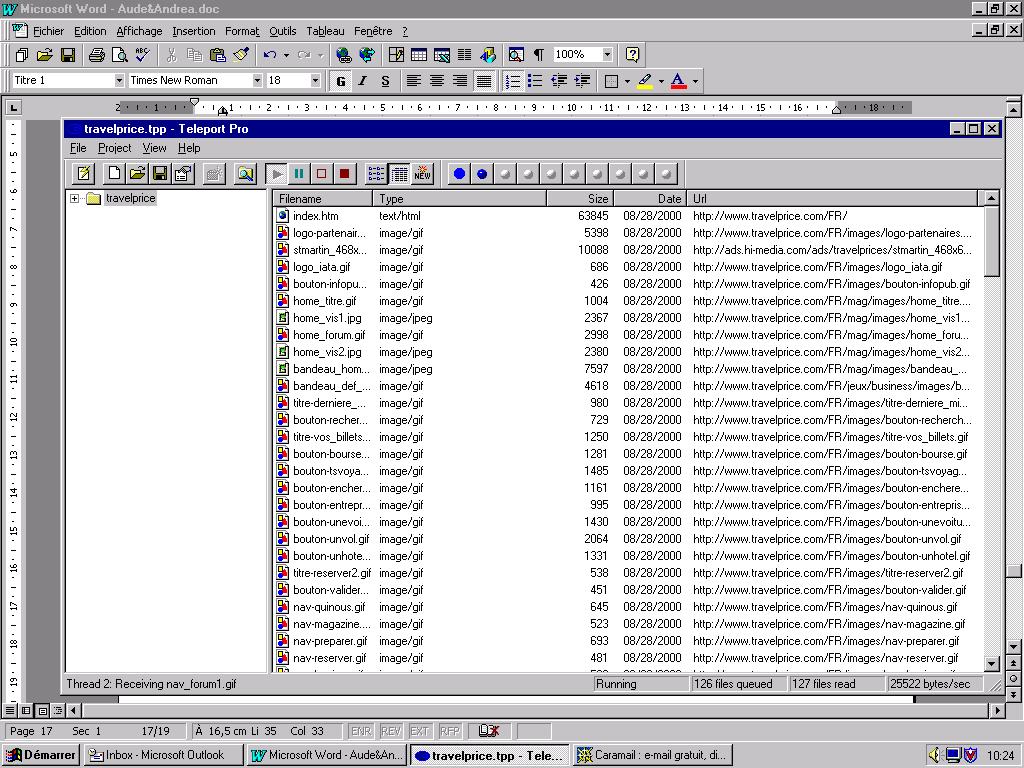

Figure 6 : Capture d’écran au moment de l’aspiration avec HTTrack 2.1. du site TravelPrice (http://www.travelprice.com/FR/)

Teleport Pro est édité et commercialisé par Tennyson Maxwell Information Systems. Il est possible de se procurer une version de démonstration sur le site web : http://www.tenmax.com/teleport/pro/.

Le logiciel propose également toute une série de paramétrages utiles tels que :

le choix de la taille maximum des fichiers à aspirer,

le choix de la taille maximum de l’ensemble des fichiers à aspirer,

le choix du type des fichiers à aspirer (applets Java, images, son),

la gestion du proxy,

la mise à jour rapide d’un miroir et la possibilité de reprendre un transfert interrompu (rupture de connexion, crash, etc.),

la structure hiérarchique du site web aspiré peut être totalement conservée,

tous les éléments qui composent le site sont enregistrés dans un même répertoire.

Toutefois, certaines options très utiles avec HTTrack 2.1. n’existent pas dans Teleport Pro. Voici celles qui nous ont le plus manquées lors de l’aspiration des sites personnels9 :

aucune possibilité de mettre une liste de sites à aspirer successivement ;

des problèmes pour aspirer les fichier flash (au format .swf). Par exemple, c’est le cas de la page personnelle : http://perso.wanadoo.fr/5sens/ ;

l’outil ne crée pas de rapport d’aspiration exhaustif en fin d’aspiration, et au cours de l’aspiration, ni la durée, ni la vitesse ne sont indiquées ;

il manque un planificateur de captures.

D’un point de vue pratique, nous nous sommes aperçues que :

il faut mettre un slach à la fin de l’URL du site à aspirer, sauf si celle-ci se termine par .com,

Teleport pro lit plus de fichiers qu’il n’en aspire et nous n’avons pas trouvé de solution à ce problème.

Bien que l’outil soit moins paramétrable que HTTrack, Teleport Pro se montre relativement rapide et il ne néglige pas pour autant la qualité de l’aspiration, bien au contraire. En effet, la qualité d’aspiration avec Teleport Pro s’est montrée très concluante.

Figure 7 : CApture d’écran au moment de l’aspiration avec Teleport Pro 1.29. du site TravelPrice (http://www.travelprice.com/FR/)

Cet aspirateur est certainement le plus connu du grand public. Il est développé par Goto Software, qui propose sur son site : http://www.goto.fr/fr/memoweb3/memoweb3.htm une version de démonstration téléchargeable.

Il propose lui aussi des options telles que :

la gestion du proxy,

la mise à jour rapide d’un miroir et la possibilité de continuer un transfert interrompu,

la possibilité d’éditer un rapport recensant les erreurs lors de l’aspiration,

la mise à disposition d’un planificateur des tâches.

En revanche, le logiciel dans sa version de démonstration impose certaines limites :

impossibilité de supprimer le logo inséré par MemoWeb en bas de chaque page capturée ;

impossibilité de capturer les images d’une taille supérieure à 200*200 ;

arrêt de l’aspirateur quand la capture atteint le niveau maximum d'erreurs. Dans ce cas, nous supposons que ce sont des erreurs d’écriture dans le code des sources des pages web ;

blocage de l’outil sans annoncer le problème : il faut donc le surveiller et s’il y a blocage, il faut relancer la capture (voire plusieurs fois).

Nous avons également été confrontées à un autre problème : souhaitant aspirer une liste d’URLs, nous avons contacté les concepteurs de ce logiciel pour savoir si nous pouvions le faire comme avec HTTrack. Voici leur réponse : « Il suffit de donner comme URL de départ une page HTML locale contenant toutes les URLs des sites à aspirer (par exemple un fichier Bookmark.htm) ou une page texte contenant la liste des URLs les unes en dessous des autres :

http://www.goto.fr

http://www.net59.fr

http://www.tf1.fr

etc…

Dans ce cas, MemoWeb transforme alors cette page texte sous forme HTML et la sauvegarde dans un répertoire que vous devez lui indiquer. Pour prendre la page locale, il suffit d'utiliser le menu "Utiliser une page locale." dans Nouveau Web, menu sur l'icône du navigateur. Attention! Au niveau d'exploration, il faut modifier la profondeur d'exploration des sites externes dans Exploration / Site Externes et mettre le niveau que vous souhaitez. »

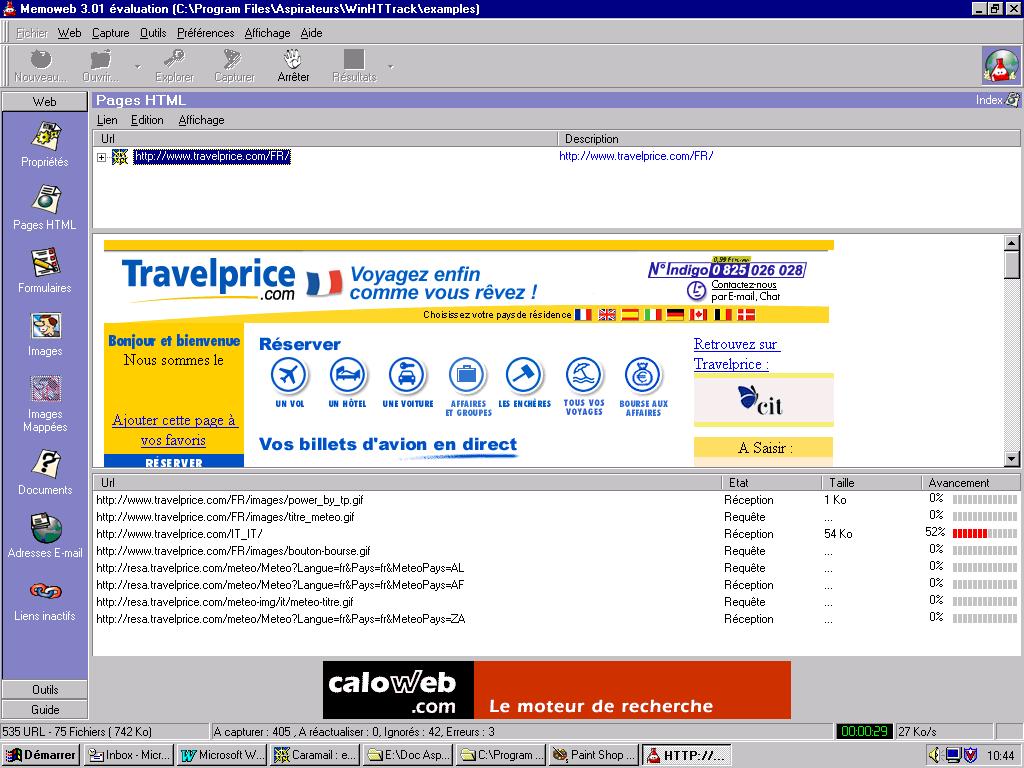

Figure 8 : Capture d’écran au moment de l’aspiration avec MemoWeb 3 démo du site TravelPrice (http://www.travelprice.com/FR/)

Pour comparer ces trois aspirateurs, nous avons retenu plusieurs critères tels que la vitesse, la qualité d’aspiration, etc., nous en proposons une synthèse dans le Tableau 1 ci-dessous.

|

|

winHTTrack 2.1 |

Teleport Pro 1.29 |

Memoweb démo.** |

|

URL de l'aspirateur |

http://httrack.free.fr/httrack_fr.html |

http://www.tenmax.com/teleport/pro/ |

http://goto.fr/fr/memoweb3/memoweb3.htm |

|

Vitesse |

rapide |

très rapide |

rapide |

|

Qualité lien* |

|

|

|

|

Qualité image* |

|

|

|

|

Mise à jour |

oui |

oui |

oui |

|

Liste des URL |

oui |

non |

oui |

|

Environnement |

Windows/Linux/Sun |

Windows |

Windows |

|

Planificateur de capture |

oui |

non |

non |

|

Langue |

français/d'autres langues |

anglais |

français/d'autres langues |

|

Résultat global |

correct |

bien |

moyen |

|

|

|

|

|

|

*tout dépend de la |

conception du site |

|

|

|

**évaluation difficile |

car version de démonstration |

|

|

Pour ce qui suit, nous n’avons pas pris en compte l’aspirateur Memoweb version de démonstration car nous n’avons pas pu obtenir un site miroir complet des sites aspirés. En effet, à chaque fois, l’aspiration atteignait le taux maximum d’erreurs et s’arrêtait.

La vitesse : Nous avons chronométré le temps d’aspiration de plusieurs sites. Nous constatons que la vitesse est dépendante de la bande passante et du moment de la journée. L’aspirateur peut aussi bien capturer à la vitesse de 20000 bytes par seconde qu’à la vitesse de 100 bytes/sec. A ce niveau, il n’y a pas de réelle différence entre HTTrack 2.1 ou Teleport pro1.29.

La qualité : La comparaison de la qualité d’aspiration, c’est-à-dire la qualité de l’aspiration des images et des liens, est un critère plus intéressant que celui de la vitesse.

Voici quelques exemples de comparaison d’aspiration sur des sites personnels et marchands :

le site personnel Addiffusion (http://perso.wanadoo.fr/addifusion)

Pour l’aspiration avec HTTrack2.1 : les liens ne fonctionnent pas et on ne peut accéder à aucune page de liens.

Pour l’aspiration avec Teleport Pro : les liens ne posent pas de problèmes et on peut aller d’une page à une autre en cliquant sur des liens.

pour le site marchand TravelPrice (http://www.travelprice.com/FR/), nous obtenons les résultats suivants :

Avec HTTrack 2.1

Temps d’aspiration : 49 min 34 sec

Qualité d’aspiration : mauvaise qualité d’aspiration (la page d’accueil n’apparaît pas à l’écran).

Avec Teleport Pro 1.29

Temps d’aspiration : 22min

Qualité d’aspiration : mauvaise qualité d’aspiration (la page d’accueil n’apparaît pas à l’écran).

pour le site personnel MSA19 (http://perso.wanadoo.fr/msa19), nous obtenons les résultats suivants :

Avec HTTrack 2.1

Temps d’aspiration : 35 sec (18000 à 19000 bytes/sec)

Qualité d’aspiration : toutes les images sont aspirées et tous les liens fonctionnent.

Avec Teleport Pro 1.29

Temps d’aspiration : 29 sec (10000 à 20000 bytes/sec)

Qualité d’aspiration : toutes les images sont aspirées et tous les liens fonctionnent.

En fonction de ces résultats, nous constatons que pour une même qualité d’aspiration, Teleport Pro a une vitesse d’aspiration supérieure à celle d’HTTrack. C’est pourquoi, nous avons choisi Teleport Pro pour l’aspiration des sites personnels Mars 2000 car on obtient un site miroir le plus fidèle possible par rapport au site en ligne avec une rapidité supérieure.

L’apparition de nouvelles technologies rend de plus en plus difficile les aspirations complètes des sites web. C’est surtout le cas pour les sites marchands qui investissent de plus en plus dans le commerce électronique et sécurisent les accès aux sites. En effet, nous avons rencontré quelques difficultés pour l’aspiration des sites marchands. Par exemple, lorsque le nom d’un site est redirigé vers une autre adresse URL, nous ne pouvions pas l’aspirer. C’est le cas de certains sites comme :

reductour car la source de la page renvoyait vers degriftour (exemple 1),

promovac (exemple 2),

la camif car la page principale renvoyait vers des liens externes (exemple 3).

Exemple 1 : le site Reductour

Le site ne peut pas être aspiré car les fenêtres ont en argument les adresses des sites extérieurs (nous avions paramétré Teleport pro pour ne pas aspirer les adresses des sites extérieurs).

Source de la page d’accueil de Promovacances

<HTML>

<HEAD><TITLE>WEB Réductour</TITLE></HEAD>

<frameset cols="100%,*">

<frame src="http://www.degriftour.com/SCRIPTS/SaISAPI.dll/CAT.class?FNC=AppelParHREF__Aportail_html___1|1___-1|-1|2|R|1">

<FRAME src="http://www.degriftour.com/images/trans.gif"></frameset>

</HTML>

Exemple 2 : le site Promovacances

Le site ne peut pas être aspiré car l’URL pour visiter le site est promovacances.com (ou promovac.com ou promovacances.fr) et ne correspond pas au nom de la source de la page principale. Toutefois en reprenant l’adresse de la source (promovacances.net), nous avons pu aspirer le site.

Source de la page d’accueil de Reductour

<html>

<head>

<title>Promovacances</title>

<meta http-equiv="Content-Type" content="text/html; charset=iso-8859-1">

</head>

<frameset rows="0,*" resizable="no" scrolling="auto" border="0" framespacing="0" frameborder="NO">

<frame src="http://www.promovacances.net/page_blanche.htm" noresize frameborder="NO">

<frame src="http://www.promovacances.net/" noresize frameborder="NO">

</frameset>

<noframes><body bgcolor="#FFFFFF">

</html>

Exemple 3 : le site Degriftour

Le site n’a pu pas être aspiré : nous pensons que le concepteur a mis un code de protection pour empêcher toute aspiration.

Source de la page d’accueil de Reductour

<HTML>

<HEAD><TITLE>degriftour.com</TITLE></HEAD>

<frameset cols="100%,*">

<frame src="/SCRIPTS/SaISAPI.dll/CAT.class?FNC=AppelParHREF__Aportail_html___1|1___-1|0|-1|D|1">

<FRAME src="/images/trans.gif"></frameset>

</HTML>

Ainsi, nous avons émis également l’hypothèse suivante : les sites marchands se protègent de plus en plus contre le « copyright » et le « piratage ».

En outre, les sites marchands deviennent de plus en plus volumineux, et par conséquent, ils sont très longs à aspirer. Effectivement, la durée d’aspiration peut varier de quelques minutes à plusieurs jours. Par exemple, nous avons mis presque une semaine à aspirer le site guetali (www.guetali.com).

En revanche, nous n’avons pas rencontré de difficultés lors des aspirations des sites de pages personnelles, même si l’état des d’aspirations n’est pas toujours parfait. L’aspiration de tous les sites de pages personnelles (au total 584 pages) a été très longue car, comme nous l’avons déjà mentionné plus haut, nous ne pouvions pas mettre une liste des URLs à aspirer successivement dans Teleport Pro : il nous a fallu rentrer toutes les adresses manuellement, une à une.

Parallèlement à l’aspiration des sites, une chaîne de traitements a été mise en place pour normaliser le corpus de sites à soumettre à l’analyse. Cette chaîne de traitements vise à organiser les informations contenues dans les pages HTML des sites (éléments de structure et éléments de contenu).

Avant de présenter les outils de la chaîne de modélisation de sites et de détailler les problèmes que nous avons rencontrés, voici un schéma qui donne une vision synthétique de la chaîne de traitements TypWeb (cf. Figure 9).

Figure 9 : Chaîne de traitement pour la constitution de corpus web

WebXref est un outil de « désossage » des éléments utilisés pour la construction de pages HTML dans des sites web, c’est-à-dire la description formelle des éléments composant une page HTML. Cet outil, appliqué sur un site complet, vise donc à produire, pour toutes les pages du site, une analyse de ces pages et la production d’un rapport détaillant l’ensemble des éléments HTML présents dans chaque page.

L’outil construit dans le cadre du projet TypWeb (Mosut, 2000) est l’adaptation du programme webxref03510, écrit par Rick Jansen en juin 1995. La mise à jour réalisée sur cet outil permet de parcourir plusieurs sites, appliquant aux documents trouvés une fonction qui extrait de manière récursive les attributs HTML et les éléments qu’ils enchâssent en vue de traitements différenciés. WebXref-VersionTypWeb produit des tableaux contenant les références des documents trouvés ainsi que les URLs, ancres, images et fichiers afférents. La fonction DissectFile utilisée dans ce programme prend appui sur les algorithmes utilisés dans le script dissectsite.hts11 disponible à l’adresse suivante : http://worldwidemart.com/scripts/.

Webxref est un programme Perl que l’on peut exécuter sur un site ou une liste de sites. Chaque ligne de commande est de la forme :

perl webxref-11.pl –option(s) <répertoire de stockage des résultats> <nom du site à désosser>

Pour illustrer notre travail, nous allons indiquer comment utiliser cet outil sur deux sites personnels (http://perso.wanadoo.fr/abarral.paradou et http://perso.wanadoo.fr/5sens). Dans ce cas-là, il faut constituer une liste de lignes de commande de la forme :

system ("perl webxref-2000-11.pl –html –at rapportPP0300/ abarral.paradou0300/");

system ("perl webxref-2000-11.pl –html –at rapportPP0300/ 5sens0300/");

que l’on stocke dans un fichier exécutable (par exemple listePP2Webxref.pl).

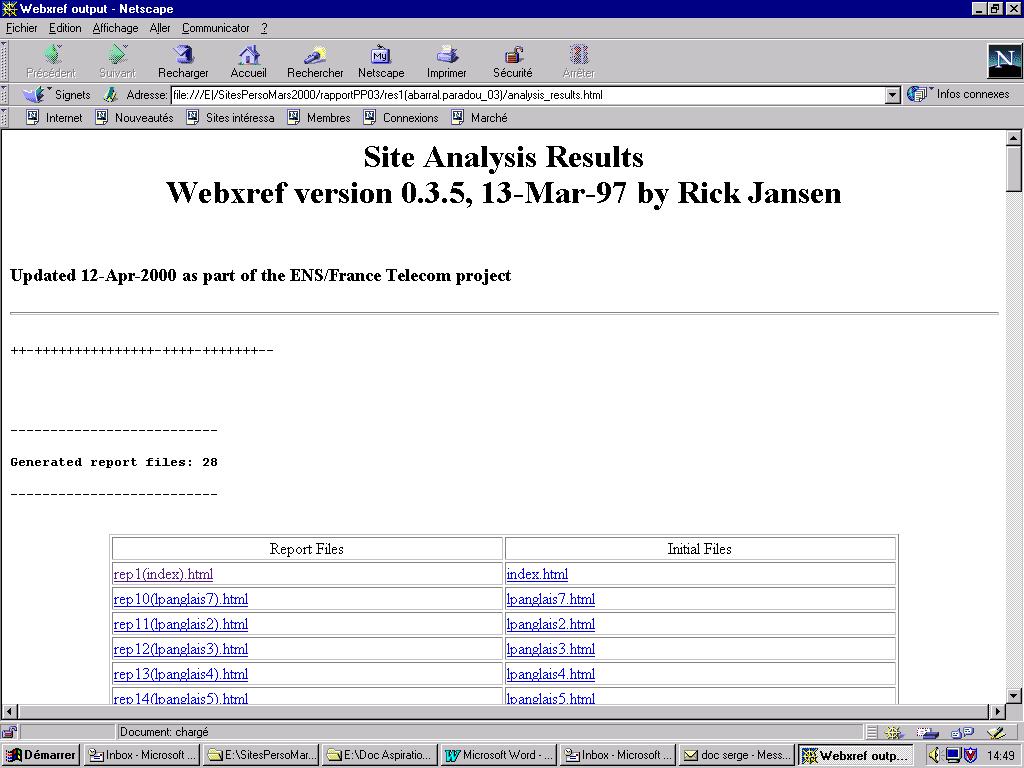

En sortie, le programme WebXref-VersionTypWeb produit une présentation de la structure formelle du site qui lui est soumis : composants structurels tels que les éléments HTML avec leurs attributs, les éléments textuels, etc. La figure suivante présente le rapport général produit pour le site abarral.paradou : ce rapport donne la liste des fichiers du site pour lesquels le programme a construit un rapport, il contient aussi des indicateurs généraux sur le site (nombre d’images, de liens externes…).

Figure 10 : Rapport WebXref-VersionTypWeb général sur le site Abarral.paradou

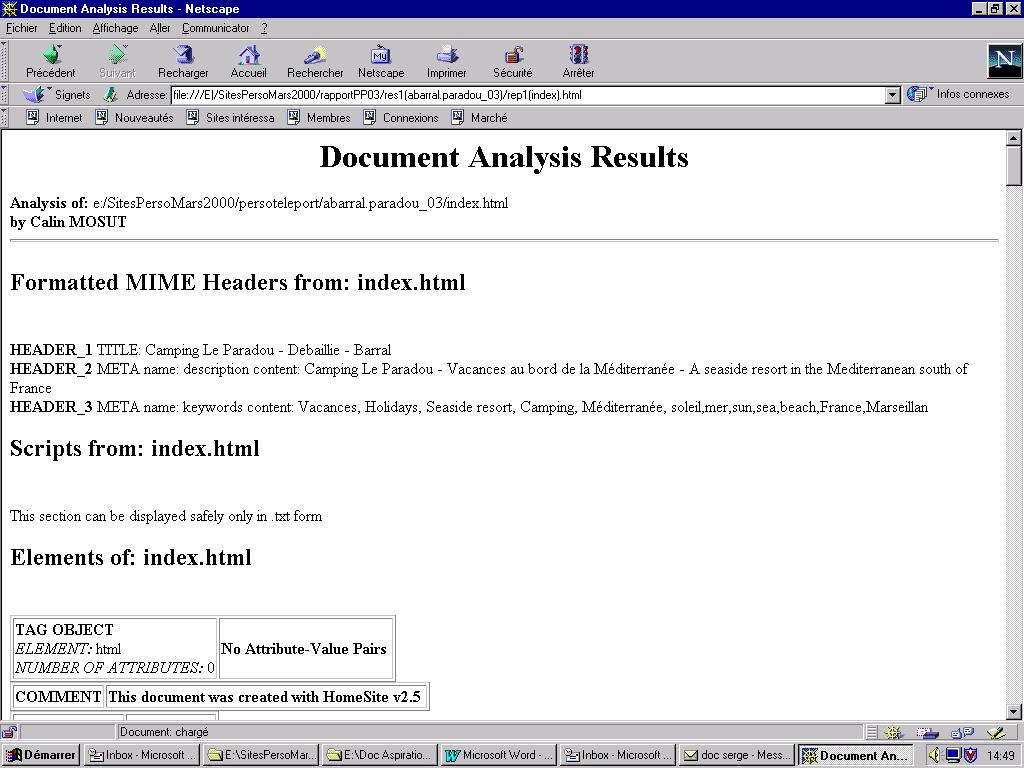

Le rapport global contient aussi des liens vers les rapports construits pour chaque page du site. Nous présentons ci-dessous (cf. Figure 11) le contenu d’un tel rapport. Celui-ci donne une description complète de tous les éléments composants la page décrite.

Figure 11 : Rapport WebXref détaillé du fichier index.html du site Abarral.paradou

Nous n’avons pas rencontré de problèmes en utilisant Webxref sur les 584 sites personnels aspirés.

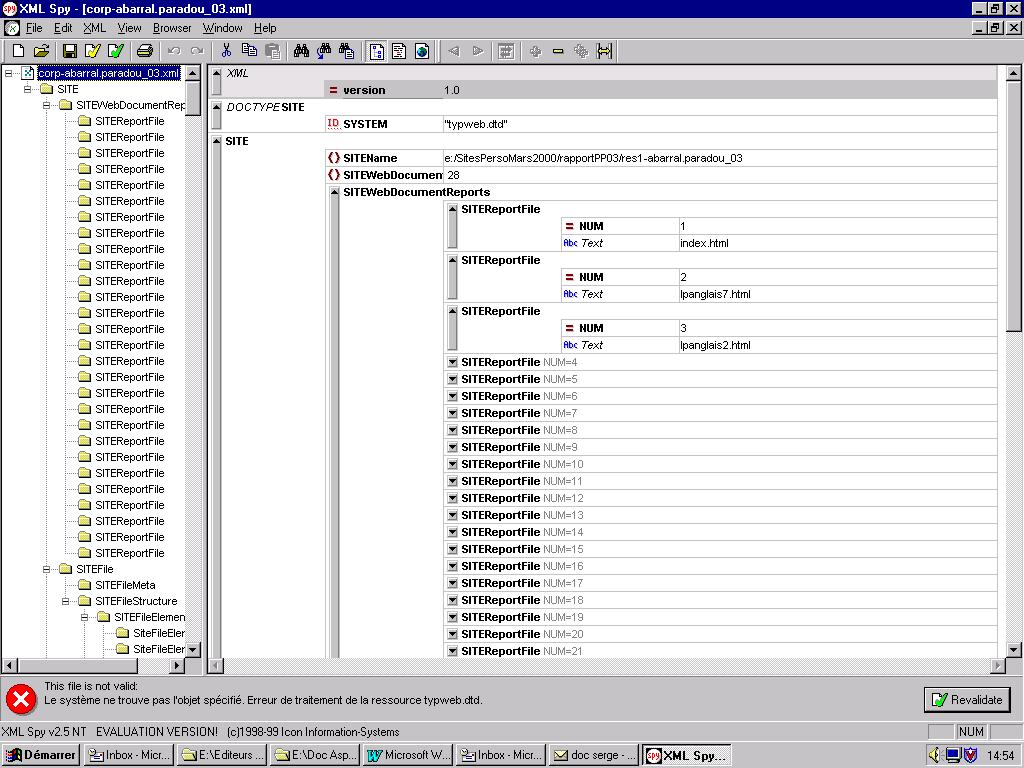

Mktipo permet de transcoder les rapports HTML générés par webxref au format XML. Plus précisément, au cours de cette étape de normalisation, on doit aboutir à la mise en place d’un modèle de document pour représenter les sites. Ces modèles doivent tenir compte à la fois de la cartographie interne du site (les arêtes du réseau de liens entre les pages du site) et du contenu multimédia des pages traités (les nœuds du réseau). Chaque nœud du réseau (les pages) étant eux-mêmes des micros-réseaux de liens : une page peut être constituée d’ancre pour faciliter la navigation.

Pour réaliser cette normalisation dans la représentation des sites, nous prenons appui sur les rapports produits par WebXref-VersionTypWeb. Ces rapports sont alors transcodés au format XML : l’ensemble des rapports pour toutes les pages d’un site est regroupé dans un format qui tient compte des éléments propres au site global (structure et contenu) et des éléments propres à chaque page (idem). Ce transcodage produit en sortie pour chaque site un état du site au format XML qui contient donc des indicateurs de nature structurelle et de contenu.

Mktipo est également un programme Perl qui prend en argument un fichier webxref. La commande générique pour exécuter ce programme est de la forme :

perl mktipo7.pl <rapport engendré par webxref>

Comme pour webxref, il est possible de lancer le programme sur une liste de fichiers de cette manière :

system("perl mktipo7.pl rapportPP0300/res1\(abaral.paradou0300\)");

system ("perl mktipo7.pl rapportPP0300/res1\(5sens0300\)");

La figure qui suit (cf. Figure 12) est le résultat obtenu sur le site abarral.paradou dans un éditeur de documents XML (ici, nous utilisons l’éditeur XML Spy, disponible à : http://www.xmlspy.com). Pour visualiser les sorties en xml, chaque site est associé à une DTD.

Figure 12 : représentation XML du site Abarral.paradou

Cette étape de normalisation permet non seulement de structurer les informations à analyser, mais aussi de délimiter les zones textuelles des sites étudiés.

En exécutant le programme sur les 584 sites personnels aspirés avec Teleport Pro, Mktipo a bloqué sur plusieurs sites. Voici la liste des sites sur lesquels Mktipo a bloqué, ainsi que les indications que l’outil donne (en effet, Mktipo indique sur quel fichier il bloque) et des explications possibles :

http://perso.wanadoo.fr/antoine.flahault

//rep1<index>.html

page à redirection

http://perso.wanadoo.fr/bourse.graphic

//rep1<index>.html

page à redirection

http://perso.wanadoo.fr/dancy.sound

//rep164<here-i-go-again>.html

la source de la page est complète mais la page ne s’affiche pas

http://perso.wanadoo.fr/gisèle.bartaland

//rep18<prevention.educnat>.html

page à redirection

http://perso.wanadoo.fr/guillaume.blanc

//rep82<sommaire>.html

http://perso.wanadoo.fr/j-françois.thiers

//rep10<alien3>.html

http://perso.wanadoo.fr/jeux.lulu

//1<index>.html

http://perso.wanadoo.fr/kiss07

//rep1<index>.html

http://perso.wanadoo.fr/midinet

//rep4<accueil>.html

http://perso.wanadoo.fr/nguyen595

//rep1<index>.html

page à redirection

http://perso.wanadoo.fr/olivier.lalorette

//rep15<menu>.html

http://perso.wanadoo.fr/sahira

//rep1<index>.html

http://perso.wanadoo.fr/ultimage3d

//rep5<basdepage>.html

http://perso.wanadoo.fr/velonin

//rep1<index>.html

Les fichiers sur lesquels Mktipo bloque mériteraient d’être explorés afin d’optimiser la chaîne de traitement.

Nous avons constitué un corpus web de sites personnels (i.e. aspirations des sites et passage à un modèle de représentation des sites). Les aléas des aspirations des sites marchands ne nous ont pas permis d’achever cette phase dans son intégralité : nous les avons uniquement aspirés.

Nous avons consacré beaucoup de temps aux aspirations mais également à la comparaison des sites archivés et en ligne. Toutefois cette étape semble indispensable pour poursuivre et comprendre les problèmes rencontrés par la suite dans l’architecture de profilage TypWeb. Ainsi, les causes possibles de mauvaises aspirations, telles que la redirection des sites personnels vers un autre hébergeur, se répercutent sur les résultats obtenus avec Mktipo (cf. § Problèmes rencontrés).

Afin d’exploiter le corpus constitué, une première étape consistera certainement à le rendre propre et utile pour toutes analyses ultérieures : étiquetage morpho-syntaxique, corpus arborés, analyse sémantique, etc.

L’exploitation du corpus dans toutes ses dimensions (structurelle et sémantique) permettra certainement de répondre aux questions restées en suspens : de quel type de corpus s’agit-il ? est-ce un nouveau type de corpus ? existe-t-il un langage spécifique au web ? le langage d’un site marchand d’un site personnel diffère-t-il ?

Abeillé A. (1993) : Les nouvelles syntaxes. Grammaires d’unification et analyse du français, Armand Colin, Paris.

Amitay E. (1997) : Hypertext : The importance of being different, Centre of Cognitive Science, University of Edinburg.

Astra Site Manager 2.0 Quick Tour (2000), Documentation en ligne sur le site : http://www-svca.mercuryinteractive.com/fr/products/astrasitemanager/.

Beaudouin V. (2000) : Sites marchands et pages personnelles : analyse de la structure formelle et sémantique des sites et étude des parcours, Rapport Interne TypWeb, France Télecom Recherche & Développements, Issy-les-Moulineaux.

Beaudouin V., Fleury S., Velkovska J. (2000) : « Etudes des échanges électroniques sur internet et intranet : forums et courriers électroniques », JADT 2000, 5èmeJournées Internationales d’Analyse Statistiques des Données Textuelles, pp. 17-24.

Beaudouin V., Velkovska J. (1999) : « Constitution d’un espace de communication sur Internet (forums, pages personnelles, courrier électronique…) », in P Flichy, éd., Internet un nouveau mode de communication ?, Réseaux n° 97, CNET – HERMES Science Publications, Paris, pp. 121-177.

Chevalier K. (1999) : Extraction intelligente d'information d'une page et d'un site web en exploitant sa typologie, Rapport de stage, CNET, DSM/GRI, Equipe Langue Naturelle.

Fuchs C. (1993) : Linguistique et traitements automatiques des langues, Hachette, Paris.

Gensollen M. (1999) : « La création de valeur sur Internet », in P Flichy, éd., Internet un nouveau mode de communication ?, Réseaux n° 97, CNET – HERMES Science Publications, Paris, pp. 15-76.

Habert B. (2000) : « Des corpus représentatifs : de quoi, pour quoi, comment ? », Actes de la journée Linguistique et corpus, Presses de l'université de Perpignan, Perpignan.

Habert B., Fabre C., Issac F. (1998) : De l’écrit au numérique. Constituer, normaliser et exploiter les corpus électroniques, InterEditions, Masson, Paris, pp. 33-49.

Habert B., Illouz G., Lafon P., Fleury S., Folch H., Heiden S., Prévost S. (2000) : « Profilage de textes : cadre de travail et expérience », JADT 2000, 5èmeJournées Internationales d’Analyse Statistiques des Données Textuelles, pp. 163-170.

Habert B., Nazarenko A., Salem A. (1997) : Les linguistiques de corpus, Armand Colin-Masson, Paris.

Illouz G., Habert B., Fleury S., Heiden S., Lafon P. (1999) : « Maîtriser les déluges de données hétérogènes », in A. Condamines, C Fabre, M.-P. Péry-Woodley, éds., Corpus et traitement automatique des langues : pour une réflexion méthodologique, TALN’99, Cargèse, Corse, pp. 37-46.

Mosut C. (2000) : Webxref version TypWeb. Mise à plat des éléments HTML des pages web, Rapport Technique, ENS Fontenay – Saint-Cloud.

Ricouard T., Joathon C., Blaison F. (2000) : « Les aspirateurs », Netsurf, n°51, juin 2000.

1 J. Sinclair (1996) : « Preliminary recommendations on Corpus Typology », Technical report, EAGLES (Expert Advisory Group on Language Engineering Standards), cité par Habert et al. (1997).

2 J. Sinclair (1996) cité par Habert et al. (1997).

3 La plupart des aspirateurs propose des paramétrages qui permettent de ne recopier que certains éléments des sites web ; par exemple, uniquement les parties textuelles d’un site web, ou bien seulement les images qu’il contient, etc.

Dans notre cas, nous souhaitons aspirer TOUS les éléments constitutifs d’un site (image, texte, sons et vidéo) et conserver la structure interne du site (hiérarchisation du site). C’est pourquoi nous voulons obtenir un site miroir identique au site accessible sur le web.

4 Les sites archivés sont des sites déjà aspirés et stockés sur CD-ROM.

5 HTTrack est un logiciel développé par deux étudiants, Xavier Roche et Yann Philippot gratuit et disponible sur le web à http://httrack.free.fr/.

6 Une page lien est une page à laquelle on accède en cliquant sur un lien.

7 En règle générale, un site web est hiérarchisé le premier niveau correspond à la page d’accueil, le deuxième niveau, à la page obtenue en cliquant sur un lien de la page d’accueil, etc. Ainsi en passant de liens en liens, on peut peu à peu descendre dans l’arborescence du site : c’est pourquoi nous parlons de niveau de profondeur.

8 Au cours de notre stage, nous avons utilisé la version 2.1 dans laquelle les problèmes de captures d’applets java sont désormais résolus.

9 Il est possible d’obtenir certaines réponses en français soit sur le site http://www.multimania.com/xpro7/teleport.htm, soit par ICQ (1396214 – Hervé).

10 Webxref 035 est distribué par le site http://www.perl/com. C'est un programme Perl conçu pour vérifier rapidement un ensemble local de pages HTML et mettre au jour les dysfonctionnements possibles : liens pointant vers des fichiers ou ancres manquants, etc.

11 Ce script est utilisable dans un navigateur, il prend en argument une URL (en ligne) et génère des variables stockant l'information sur les en-têtes et les éléments envoyés par le serveur (" text objects " ou " tag objects "). Les résultats produits sont présentés au format HTML dans une nouvelle fenêtre du navigateur.