La Evolución del Estadístico: ¿Data Scientist?

Es innegable la popularidad que está alcanzando la importancia de manejar grandes cantidades de datos. Las empresas públicas y privadas del país incorporan cada vez más a profesionales que puedan cumplir roles de analistas de información. Se empiezan a crear puestos de primera línea ligados directamente a la gestión de los activos de información dentro de la compañía. Puestos de trabajo nunca antes vistos, pues ahora ya no es difícil encontrar directores y gerentes de Inteligencia Comercial.

Sin embargo en comparación con el resto del mundo aún estamos en una etapa inicial. Estamos en la etapa de explosión del Business Intelligence cuando el resto del mundo está hablando de Big Data.

¿Qué tendría que pasar para tratar de alinearnos al resto del mundo?

Empecemos por comprender que es Big Data. En palabras sencillas Big Data se refiere a las técnicas, herramientas y metodologías para almacenar, procesar, analizar y visualizar grandes cantidades de datos.

¿Qué tan grande? En términos de Peta bytes, pero no sólo debemos hablar de volumen de datos. No olvidar también la velocidad con la que crece esta información. Por último la variedad; en Big Data, tenemos: data transaccional, social, texto, móvil, audio, imagen, vídeo, streaming y más.

Entonces decimos que Big Data se refiere a las 3V: Volumen, Variedad y Velocidad de crecimiento de los datos.

Empresas como Google, Amazon, Facebook, Walmart, Ebay, Apple entre otras han comenzado hace muchos años a utilizar las herramientas de Big Data dentro de sus procesos de toma de decisiones.

Entonces ¿Qué tipo de profesionales requiere Big Data?

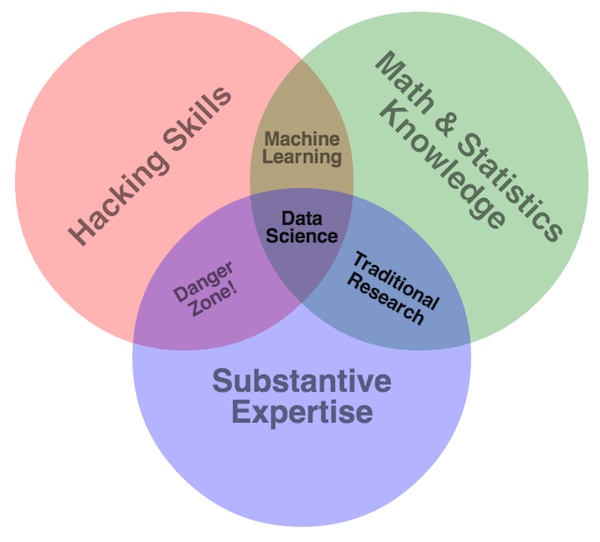

Los profesionales más alineados a poder solucionar los problemas de Big Data se conocen como Data Scientist. Estos deben desarrollarse fuertemente en campos como: Matemática, Estadística, Computación; y otras áreas no menos importantes como: Data Warehousing, Reconocimiento de Patrones y Aprendizaje, Visualización y optimización computacional.

Es importante que los Data Scientist dominen por lo menos 2 de estos campos y tengan conocimientos muy avanzados en los otros. Dado que gran parte de su trabajo es desarrollar herramientas para nuevos y complejos problemas.

Las herramientas que se utilizan en Big Data además de las tradicionales hasta el momento son:

- Hadoop. Es un framework o plataforma de archivos de sistema distribuidos. Lo que nos permite dividir grandes cantidades de datos en formatos más pequeños.

- Python. Un nuevo lenguaje de programación.

- R. El lenguaje estadístico por excelencia.

- Pig. Es la herramienta para ETL en Hadoop.

- Hive. Utilizando las tradicionales sentencias de SQL para realizar los reportes de BI.

En conclusión un Data Scientist es alguien que sabe más de estadística que un científico en computación y sabe más de computación científica que un estadístico.

Data Scientist = Estadístico + Programador + Coach + Artista.

¿En base a lo anterior, están preparados los estadísticos y los ingenieros en computación para asumir los retos del Big Data?

¿Lo estás tú?

Deja un comentario